Tutorial áudio

9 dicas de design de som para mixagens maiores e mais completas

Publicado

5 anos agoon

Por

Marlon Porto

Pode ser extremamente fácil mixar e masterizar uma faixa, mas o que acontece com o som quando ele sai dos alto-falantes?

Usando o conhecimento básico sobre os princípios psicoacústicos, você pode encontrar maneiras criativas de trazer aos seus ouvintes uma experiência mais poderosa, clara e “maior do que a vida”. Ao compreender como nossos ouvidos interpretam os sons, podemos recriar de forma criativa e artificial certas respostas a determinados fenômenos de áudio, particularmente EQ, compressão, e ressonâncias. E aqui 9 dicas de design de som para você usar em suas mixagens que lhe ajudarão a atingir esses objetivos:

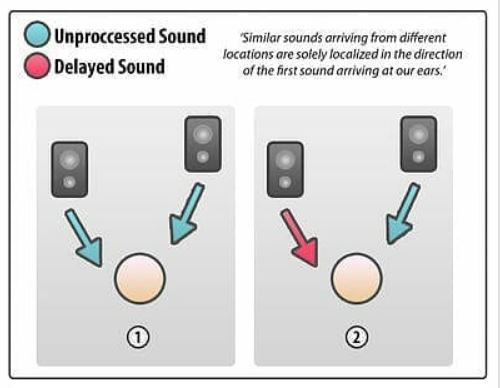

1. O efeito Haas

Nomeado após o Dr. Helmut Haas (que primeiro descreveu o efeito em 1949), este princípio pode ser usado para criar uma ilusão de largura estéreo espaçosa … começando com apenas uma única fonte mono.

Haas estava estudando como os ouvidos interpretavam a relação entre os sons originários e seus “primeiros reflexos” dentro de um espaço. Sua conclusão foi que, desde que as primeiras reflexões e cópias idênticas dos sons originais sejam ouvidas menos de 35ms depois (e em um nível não superior a 10dB mais alto que o original), os dois sons serão interpretados como um só.

A direção do som original seria preservada, mas por causa da sutil diferença de fase, as reflexões iniciais / cópia atrasada adicionariam presença espacial extra ao som percebido.

O efeito Haas na prática

Para engrossar e / ou espalhar uma fonte de som mono, é um bom truque duplicar a parte e, em seguida, deslocar cada camada para os lados. Então, você pode atrasar uma das camadas por cerca de 10-35ms. Isso engana o cérebro para perceber mais largura e espaço, enquanto deixa o centro totalmente aberto para outros instrumentos.

Você também pode usar essa técnica para afastar um sinal mono de um centro ocupado para evitar o mascaramento de outros instrumentos. Ao mesmo tempo, você não quer desequilibrar a mixagem apenas deslocando para um lado ou para o outro. A resposta está em “aumentar” e girar seu sinal mono para os dois lados.

Considere o uso de pequenos atrasos

Claro, não há nada que o impeça de atrasar um pouco um lado de um som estéreo real. Por exemplo, você pode querer espalhar seu pad de sintetizador etéreo em proporções épicas. Esteja ciente de que, ao fazer isso, você também estará deixando-o mais “desfocado”. Mas para almofadas e guitarras de fundo, isso geralmente é totalmente apropriado.

Conforme você brinca com a configuração do tempo de atraso, você notará que atrasos muito curtos resultam em um som fora de fase bastante desagradável. Enquanto isso, atrasos muito longos quebrarão a ilusão e você começará a ouvir dois sons distintos e separados. Você quer algo intermediário.

Encontre o equilíbrio certo

Lembre-se: quanto menor for o tempo de atraso, mais suscetível será o som a indesejáveis comb filtering quando os canais são somados a mono. Isso é algo a se considerar se você estiver fazendo música principalmente para clubes, rádio ou outros ambientes de reprodução mono.

Você também vai querer ajustar os níveis de cada lado (em relação um ao outro) para manter o equilíbrio certo na mixagem e o equilíbrio esquerdo / direito geral desejado dentro do espectro estéreo. Você pode aplicar efeitos adicionais a um ou ambos os lados, como modulação controlada por LFO sutil ou efeitos de filtro.

Não exagere

Em uma mixagem completa, use o efeito Haas em um ou dois instrumentos, no máximo. Isso ajuda a evitar a propagação estéreo que soa como uma mistura de fases.

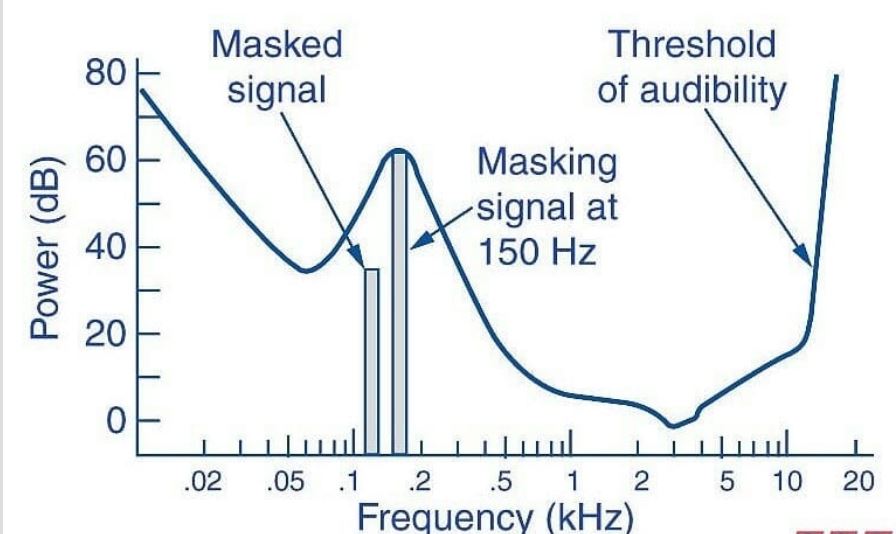

2. Teoria da frequência: como o mascaramento funciona

Existem limites para o quão bem nossos ouvidos podem diferenciar sons que ocupam frequências semelhantes à audição humana.

O mascaramento ocorre quando dois ou mais sons estão exatamente na mesma frequência. Geralmente, o som mais alto irá obscurecer parcial ou completamente o outro, que então parece “desaparecer” da mixagem.

Imagem: Sound On Sound

Obviamente, este é um efeito bastante indesejável, e é uma das principais coisas a serem observadas durante o processo de composição, gravação e mixagem. É também um dos principais motivos pelos quais o EQ foi desenvolvido, que pode ser usado para eliminar as frequências de mascaramento durante o estágio de mixagem.

Nosso truque de áudio? Evite problemas de mascaramento durante a escrita e arranjos de estágios, usando ótimos sons que ocupam suas próprias faixas de frequência.

Mesmo se você tiver tomado precauções, o mascaramento ainda ocorrerá às vezes e pode ser difícil determinar por que certos elementos soam diferentes solados em comparação com o som na mixagem completa.

Embora as notas raiz / frequências dominantes ocupem a maior parte do espaço de um som, os harmônicos de um som (que também contribuem para o timbre geral) também aparecem em frequências diferentes. Eles podem estar mascarados, o que é um ponto em que o EQ pode ajudar.

3. O reflexo acústico do ouvido

Quando confrontados com um estímulo de alta intensidade, os músculos do ouvido médio se contraem involuntariamente. Isso diminui a quantidade de energia vibracional enviada à cóclea sensível – a parte do ouvido que converte as vibrações sônicas em impulsos elétricos para processamento pelo cérebro. Basicamente, os músculos se fecham para proteger as estruturas mais sensíveis do ouvido.

Por causa disso, os músculos do ouvido respondem da mesma maneira, mesmo com sons mais suaves (se houver um transiente alto inicial seguido por uma redução imediata). O cérebro ainda interpreta isso como um “ruído alto sustentado”.

Este princípio é freqüentemente usado em técnicas de design de som cinematográfico e é particularmente útil para simular o impacto fisiológico de explosões massivas e tiros de alta intensidade (sem induzir ações judiciais por danos auditivos).

Você pode fazer uma explosão parecer bem alta desligando artificialmente o som após o transiente inicial. O cérebro vai perceber imediatamente que está mais alto e mais intenso do que o som realmente é. Isso também funciona bem para estrondos, impactos e até mesmo quedas em um clube ou pista eletrônica.

4. Crie potência e volume, mesmo em baixos níveis de audição

Se você tirar apenas uma coisa deste artigo, faça assim: A resposta de frequência natural dos ouvidos é não linear. Nossos ouvidos são mais sensíveis às frequências médias do que aqueles que ficam nas extremidades altas e baixas do espectro. Geralmente não notamos isso, pois nossos cérebros levam em consideração o viés de médio alcance. No entanto, torna-se mais aparente durante a mixagem, onde os níveis relativos dos instrumentos (em diferentes frequências) mudam dependendo do volume geral de escuta.

Mesmo que seus próprios ouvidos sejam um obstáculo para obter uma combinação perfeita, existem soluções simples para esse fenômeno. Você pode manipular a resposta não linear dos ouvidos a diferentes frequências e volumes para criar uma impressão aprimorada de volume e intensidade em uma mixagem – mesmo quando o nível de audição real é baixo.

O fenômeno Fletcher-Munson

Este fenômeno auditivo não linear foi escrito pela primeira vez em 1933 pelos pesquisadores Harvey Fletcher e Wilden A. Munson. Embora os dados e gráficos que eles produziram tenham sido aprimorados, eles eram próximos o suficiente. “Fletcher-Munson”Ainda é usado como uma frase abreviada para tudo relacionado a: “ contornos de volume iguais ”.

Essencialmente, conforme o volume real de um som muda, o volume percebido por nosso cérebro muda em uma taxa diferente, dependendo da frequência. Isso significa que você pode ouvir uma mixagem em volume baixo e achar que soa bem, mas depois ouvir a mesma mixagem em volume alto e achar que o equalizador está completamente desligado.

Recomendo ouvir suas mixes nos seguintes padrões de volumes: 60 dbs, 74 dbs (74 dbs – onde se encontra uma melhor linearidade de percepção timbral do ouvido humano ) e 85 dbs. Em volume mais baixos confira os medios e os agudos e acima de 80 dbs confira o low end e o os subs graves de todos os intrumentos presentes na mix para manter o equilibrio e a energia sônica na mixagem. Use um decibelímetro para esse fim. (Marlon Porto)

Pense no seu público

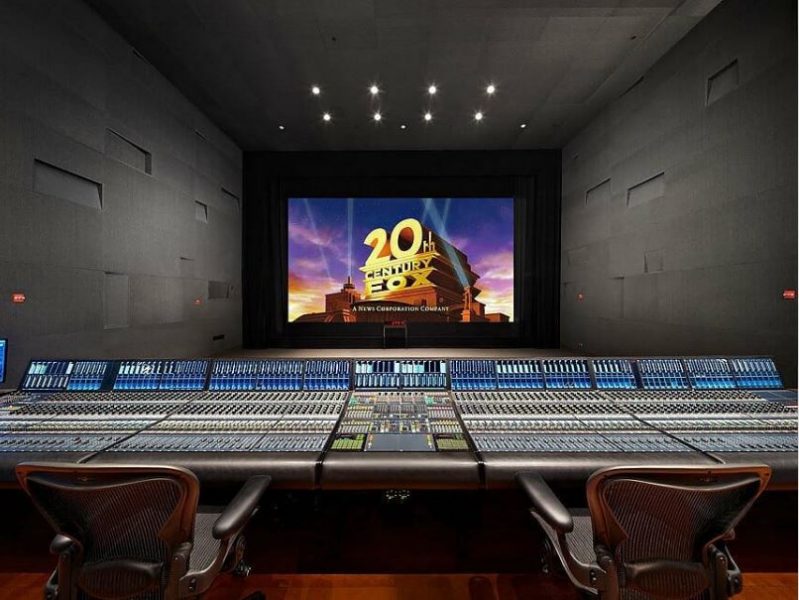

Em certas situações (como mixagem de som para filmes), é melhor mixar no mesmo nível e em um ambiente semelhante onde a música será eventualmente ouvida. É por isso que os cinemas de dublagem parecem cinemas reais e são projetados para soar como eles também.

As melhores mixagens resultam de levar em consideração o ouvinte final e seu ambiente, não necessariamente mixando algo que soa muito bem em um estúdio de um milhão de dólares.

Mixagem em escala de cinema no Skywalker Sound

Então, como a sensibilidade de nossos ouvidos à gama média se manifesta em um nível prático? Tente reproduzir qualquer peça musical em um nível baixo. Agora, aumente gradualmente. À medida que o volume aumenta, você pode notar que o viés de “aumento médio” do seu aparelho auditivo tem menos efeito, e os sons de alta e baixa frequência parecem proporcionalmente mais altos (e mais próximos, sobre o que falaremos na próxima dica).

Dado que as frequências extremamente altas e baixas se destacam mais quando ouvimos efeitos sonoros altos, podemos criar a impressão de volume em níveis de audição mais baixos, atenuando a faixa média e / ou aumentando as extremidades altas / baixas do espectro. Em um equalizador gráfico, pareceria uma carinha sorridente, e é por isso que os produtores falam em “pegar a faixa intermediária” para adicionar peso e potência a uma mixagem.

Como aplicar este truque de áudio

Esse truque pode ser aplicado de várias maneiras, desde tratar toda a mixagem até algum equalizador amplo (cuidadoso) durante a mixagem / masterização até a aplicação de uma “concha” em um ou dois instrumentos de banda larga ou hastes de mixagem (ou seja, o submix de bateria e guitarra). À medida que você ganha experiência e põe sua cabeça em torno deste princípio, você pode construir seus arranjos de faixa e escolhas de instrumentação com uma dinâmica geral de frequência – desde o início.

Isso é especialmente eficaz para estilos como drum and bass, onde mixagens de som ricas e surpreendentemente impactantes podem ser obtidas com apenas alguns elementos que realmente funcionam nas extremidades do espectro de frequência. A mesma técnica também funciona com o rock: basta ouvir a produção de Butch Vig no Nirvana para um exemplo clássico de dinâmica intermediária.

Lembre-se de ser sutil: é fácil exagerar em qualquer tipo de amplo ajuste de frequência em uma mixagem inteira. Na dúvida, deixe para masterização.

5. Sonoridade igual, parte II: Fletcher-Munson contra-ataca

Para fazer as coisas parecerem mais distantes, reduza os altos e baixos extremos de um som em vez de aumentá-los. Isso cria a ilusão de profundidade em uma mixagem e empurra certos instrumentos para uma distância imaginária. Então, o primeiro plano fica claro para os elementos principais.

Como exemplo, isso é particularmente útil para destacar um vocal principal na frente de uma série de vocais de apoio. Também é uma escolha sólida para submixes de bateria de equalização para garantir que a bateria seja forte, mas não “na sua cara”. Um toque de reverberação também é uma opção aqui, naturalmente.

6. Os transientes parecem mais silenciosos do que os sons sustentados

O ouvido humano não percebe sons curtos tão altos quanto os sustentados quando estão exatamente no mesmo nível. Isso é conhecido como RMS, este é o princípio auditivo chave por trás de como a compressão torna as coisas mais altas e emocionantes, sem realmente aumentar o nível de pico.

Comprimir a cauda de um som engana o cérebro fazendo-o pensar que o som é significativamente mais alto e forte. Mas o nível de pico – o transiente – não mudou. É assim que os compressores permitem que você extraia cada grama de headroom disponível de seus sons e mixagens. Apenas tome cuidado para não “achatar ” sua mixagem com muita compressão.

7. Reverberar “ambiente” de reflexão precoce para sons mais densos

Se você combinar parte do princípio do efeito Haas com nossa dica anterior sobre sons sustentados, você já entenderá como adicionar reflexos iniciais de um plug-in de reverberação pode engrossar os sons de maneira atraente.

Isso pode ser usado para multiplicar e espalhar o ataque transiente inicial de um som por um período de tempo muito curto. Ao estender essa parte mais alta do som, obteremos um som um pouco mais denso, mas de uma forma muito natural e ambiente que pode ser esculpida e ajustada em tons com vários controles de reverberação. Com os efeitos de distanciamento e difusão de uma cauda longa, você pode manter o caráter inicial de um som.

8. Desacople um som de sua fonte

A fonte de um som e como ele é percebido em um contexto final podem ser coisas completamente diferentes.

Este princípio é amplamente explorado no design de efeitos sonoros de filmes, onde os melhores designers de som são capazes de dissociar completamente as qualidades sônicas de um som de sua fonte original. Foi assim que o vencedor do Oscar Ben Burtt criou o som icônico do sabre de luz de Star Wars :

“Eu tinha um fio quebrado em um dos meus microfones, que tinha sido colocado ao lado de um aparelho de televisão e o microfone pegou um zumbido, um estalo, do tubo de imagem – exatamente o tipo de coisa que um engenheiro de som normalmente rotularia de erro. Mas às vezes o som ruim pode ser seu amigo. Gravei aquele zumbido do tubo de imagem e combinei com o zumbido [de um projetor de filme antigo], e a mistura se tornou a base para todos os sabres de luz. ”

Ben Burtt, The Sounds of Star Wars

Os fins realmente podem justificar os meios

Esteja você criando efeitos sonoros para um filme ou mixando uma banda de rock, você não precisa se contentar com os sons crus ou de instrumentos com os quais começou. Se você achar que as panelas de cozinha oferecem sons que se encaixam melhor na sua faixa do que um kit de bateria caro e afinado, use-as! Se você descobrir que os brays elefantinos agudos são o complemento perfeito para sua linha de baixo dubstep cut-up (funcionou para o Skrillex), então, por favor, reúna-os.

A única coisa que importa é o resultado final percebido. Ninguém liga para os ouvidos de como você chegou lá. Eles ficarão subliminarmente muito mais entusiasmados e envolvidos por sons vindos de uma fonte incomum, mesmo que esses sons tomem o lugar de um instrumento convencional.

9. Como fazer uma mixagem soar mais completa

Nossos ouvidos podem ter problemas para decifrar onde um som termina e outro semelhante começa, mas eles são incrivelmente tolerantes quando se trata de sons em camadas. Quando feito com cuidado – mesmo em amplas faixas do espectro de frequência – os componentes separados serão lidos como um grande som texturizado.

Livros como a arte prática do som de filmes discutem a criação de efeitos sonoros em camadas como se fossem acordes. Um único efeito é composto de vários sons individuais, cada um ocupando sua própria faixa de frequência (esta é a chave para evitar mascarar sons).

Use esta técnica para colocar pilhas de partes de guitarra ou sintetizador em paredes de som que podem ser espalhadas pelo campo estéreo com o efeito Haas. As possibilidades de enganar nossos ouvidos são infinitas!

Meus comentários extras

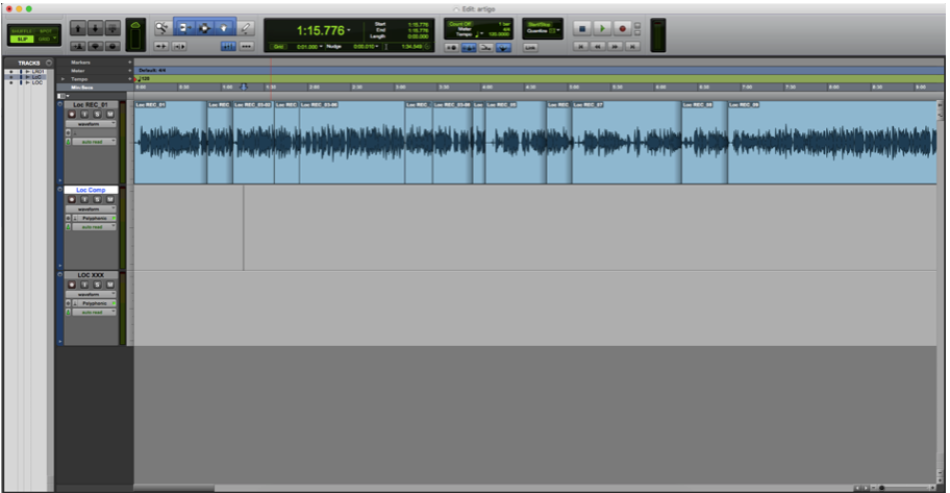

Um bom plugin para dobra de um sinal monofônico para simulação de som estéreo é o H-delay da WAVES em 30 ms de atraso conforme imagem abaixo:

Nessa matéria, você observa técnicas mais avançadas de como fazer a sua mix “crescer” no aspecto auditivo humano, mas essas técnicas se aplicam em sua maioria em casos mais profissionais de mixagens onde as exigências são maiores, se não for o seu caso, concentre-se nas bases de uma boa mix: Boa execução e gravação, arranjos bem feitos e bem distribuidos, um bom grid de bateria e bass e um bom processo de mixagem. Essas são as bases inciais de uma boa mix, deixe para aplicar as dicas acima após o dominio completo das “Bases de uma boa mix” .

Compilação, tradução, revisão e comentários extras feitos por: Marlon Porto (técnico de mixagens e masterizações da Promaster studios). Acesse o site para serviços ou cursos: www.promasterstudios.com

Você pode gostar

-

Guia prático: Mixando com a masterização em mente

-

O poder da simplicidade na mixagem

-

Áudio: Por que ir além do básico em suas mixagens?

-

Guia definitivo para a compra de plugins de áudio

-

Inteligência artificial na música: recortes, fatos e análises

-

Vídeo: Qual a importância do summing analógico no processo das masterizações musicais?

Audio Profissional

Inteligência artificial na música: recortes, fatos e análises

Publicado

3 anos agoon

24/08/2023Por

Marlon Porto

Nesse artigo consideramos o impacto da IA (Inteligência artificial) no processo criativo e técnico da produção musical.

Um setor em particular, a pós-produção de áudio, está passando por mudanças mais rápidas devido a AI. Isso significa grandes mudanças, agora e no futuro, para habilidades, emprego e trabalho. Muitos relatos sobre o papel da automação de máquinas na instabilidade ocupacional – especificamente, reduções no emprego humano. Essa artigo mostra em tópicos como esse processo está começando a alterar a cadeia de produção musical e também as novas tecnologias que podem substituir ou aumentar o potencial humano nessa área.

1 – O que é inteligência artificial?

A inteligência artificial (IA) é um ramo abrangente da ciência da computação preocupado com a construção de máquinas e algoritmos inteligentes capazes de realizar tarefas que normalmente requerem inteligência humana. Embora a IA seja uma ciência interdisciplinar com várias abordagens, os avanços no aprendizado de máquina e no aprendizado profundo , em particular, estão criando uma mudança de paradigma em praticamente todos os setores da indústria de tecnologia.

A inteligência artificial permite que as máquinas modelem, ou até melhorem, as capacidades da mente humana. E desde o desenvolvimento de carros autônomos até a proliferação de ferramentas generativas de IA como ChatGPT e Googles Bard, a IA está se tornando cada vez mais parte da vida cotidiana das pessoas comuns e dos profissionais.

2 – As primeiras aplicações da IA no áudio

As primeiras tentativas de música gerada por computador apareceram na década de 1950 com foco na criação de música algorítmica. O advento da música gerada por computador por pioneiros como Alan Turing com o computador Manchester Mark II abriu múltiplas possibilidades de pesquisa em inteligência musical onde sistemas computacionais poderiam reconhecer, criar e analisar música.

Turing ajudou a criar uma das primeiras gravações de música de computador, reaproveitando sons de sinal em um dos primeiros computadores de Manchester. Foto da Biblioteca de imagens da Science & Society.

Especificamente, os primeiros experimentos se concentraram na composição algorítmica (um computador que usa conjuntos formais de regras para criar música). Em 1957, vimos a primeira obra composta exclusivamente por inteligência artificial — Illiac Suite for String Quartet.

Lejaren Hiller e Leonard Isaacson. Foto do Illinois Distributed Museum

Através do uso de modelos matemáticos e algoritmos, Lejaren Hiller (um compositor americano) e Leonard Isaacson (um compositor e matemático americano) criaram Illiac Suite, a primeira peça original composta por um computador. Para conseguir essa façanha, eles usaram um algoritmo de Monte Carlo que gerava números aleatórios que correspondiam a certas características musicais como tom ou ritmo. Usando um conjunto de restrições, essas características aleatórias foram limitadas a elementos que seriam musicalmente ‘legais’ conforme definido pelas regras da teoria musical tradicional, probabilidades estatísticas (como cadeias de Markov) e a imaginação dos dois compositores.

Outro inovador neste campo foi Iannis Xenakis, um compositor e engenheiro, que usou probabilidades estocásticas para auxiliar na criação de sua música. Um processo estocástico é um mecanismo com distribuições de probabilidade aleatórias que não podem ser previstas, mas podem ser analisadas estatisticamente. No início dos anos 60, ele utilizou computadores e a linguagem FORTRAN para entrelaçar múltiplas funções de probabilidade para determinar a estrutura geral e outros parâmetros (como tom e dinâmica) de uma composição.

Xenakis modelou sua música como se estivesse modelando um experimento científico. Cada instrumento era como uma molécula e passaria por seu próprio processo estocástico e aleatório para determinar seu comportamento (a frequência do tom e a velocidade de certas notas). Seu trabalho introduziu novos métodos para a criação de som, mas também serviu como um dos primeiros exemplos de IA funcionando como uma ferramenta de análise complementar, em vez de apenas uma ferramenta de composição. A forma como Xenakis criava suas melodias e orquestrações para diferentes instrumentos se inspirava nos espaços sonoros modelados pelo processo estocástico.

Em 1965, o inventor Ray Kurzweil estreou uma peça para piano criada por um computador capaz de reconhecer padrões em várias composições. O computador foi então capaz de analisar e usar esses padrões para criar novas melodias. O computador estreou no programa de perguntas e respostas I’ve Got a Secret e deixou os apresentadores perplexos até que o astro de cinema Henry Morgan adivinhou o segredo de Ray.

Em 1997, um programa de inteligência artificial chamado Experiments in Musical Intelligence (EMI) parecia superar um compositor humano na tarefa de compor uma peça musical para imitar o estilo de Bach . (Fonte: Wikipedia )

3 – Período de transição – Modelagem generativa (1980 – 1990)

Nas décadas que antecederam a era moderna da música, o foco mudou da geração algorítmica mais simples para a modelagem generativa. Otto Laske, proeminente pesquisador no campo da áudio, descreve essa mudança como a diferença entre um robô musical e uma inteligência musical.

Um robô musical é mais parecido com os primeiros experimentos dos anos 50 e 60 – ele pode reconhecer padrões, tem uma gramática para música e tem um senso geral de resolução de problemas, mas atinge seus objetivos com métodos bastante diretos e contundentes. Por outro lado, a inteligência musical substitui a abordagem de busca de força bruta do robô por um sistema de compreensão baseado em conhecimento com sua própria consciência de como os elementos musicais podem funcionar. Essa tendência de sistemas de IA construírem sua própria compreensão autossuficiente de elementos musicais foi a base para a inteligência musical mais sofisticados que vemos hoje. Outros desenvolvimentos neste período continuaram a explorar os limites da criatividade computacional. Por exemplo, Robert Rowe criou um sistema em que uma máquina pode inferir a métrica, o andamento e as durações das notas enquanto alguém toca livremente em um teclado. Também em 1995, a Imagination Engines treinou uma rede neural com melodias populares, ativando o aprendizado por reforço, levando à geração de mais de 10.000 novos refrões musicais. O aprendizado por reforço envolve o treinamento de uma rede neural para atingir um objetivo, recompensando/punindo o modelo com base nas decisões que ele toma para atingir um objetivo especificado.

4 – Período atual (anos 2000 – presente)

Durante a década de 2010, testemunhamos o surgimento de algoritmos de aprendizado de máquina inteligentes e rápidos e sua integração gradual em software de produção musical. Agora, os cérebros artificiais de incontáveis plug-ins, plataformas, suítes de masterização virtual (https://www.landr.com) e até mesmo compositores estão prontamente ao volante como motoristas conscientes das ferramentas criativas de hoje.

Vejamos abaixo alguns desses aplicativos inteligentes:

Síntese Vocal Avançada: Os clones vocais deepfake de artistas famosos provocaram sentimentos contraditórios na indústria da música. No entanto, no fundo, os mesmos avanços estão ajudando a empurrar a síntese vocal para um novo território.

Tentar construir uma voz humana com um computador não é nada novo. Um sintetizador de canto como o VOCALOID6 tem uma história que remonta aos anos 2000 e, em sua iteração mais recente, começou a usar IA para melhorar o instrumento de voz sintetizada. Você pode digitar as letras, selecionar o tom e ajustar o sotaque. Pode cantar em japonês e inglês e, a partir de 2023, chinês também.

Assim como qualquer instrumento de software, como um piano virtual, ele tenta recriar a coisa real. Mas ao contrário de como a música deepfake é criada , a empresa trabalhou com cantores reais para desenvolver vários perfis vocais.

Se você está procurando uma alternativa mais jovem, experimente o Synthesizer V da Dreamtonics . A empresa foi fundada em 2019 no momento em que a tecnologia de IA começou a acelerar e atingir o status de mainstream, e os resultados são impressionantes

Concebido pela primeira vez em 2001, o Continuator era um software de aprendizado de máquina. Ele reuniu dados sobre como os músicos tocavam e aprendeu a complementá-los de maneira inteligente, improvisando em tempo real usando os dados coletados sobre como eles tocavam como modelo. Seu inventor, François Patchet, viria a ser um grande jogador no desenvolvimento do Spotify.

Entre as primeiras grandes aplicações de IA em plug-ins de mixagem de música, o Adaptiverb da Zynaptiq inspeciona o áudio de origem e, usando o ressintetizador Bionic Sustain, cria a cauda de reverberação perfeita e sob medida, por meio de centenas de osciladores em rede. Ele estabeleceu um novo precedente para destacar os benefícios práticos do aprendizado de máquina em toda a produção.

Tecnologia Assistiva de Áudio da iZotope (2016)

Izotope; uma empresa que abraçou o potencial de economia de tempo da IA como poucas outras, a útil tecnologia de áudio assistido da iZotope é o molho secreto por trás de produtos emblemáticos como RX de aprimoramento de áudio e Ozone de aperfeiçoamento de som. Ao analisar o áudio de forma inteligente e aplicar correções rápidas, o iZotope provavelmente economizou coletivamente anos preciosos dos profissionais no estúdio.

5 – Como a IA está mudando a tecnologia de áudio

“Uma vez que o método de pensamento da máquina tivesse começado, não demoraria muito para superar nossos fracos poderes. Eles seriam capazes de conversar uns com os outros para aguçar sua inteligência. Em algum momento, portanto, devemos esperar que as máquinas assumam o controle”. Assim como a previsão sombria que o pai da inteligência artificial, o gênio da computação Alan Turing previu. Embora, felizmente, ainda não estejamos enfrentando um ponto final tão assustador, a noção de Turing de um cibercérebro controlado por uma máquina, continuamente aguçando seus sentidos por meio de diálogo e refinamento constantes, é um conceito que está no cerne da aplicação comercial de inteligência artificial

Em nossa indústria, podemos ver isso talvez mais claramente do que qualquer outro. Multidões de ferramentas de software baseadas em IA agora disponíveis, que se destacam em tarefas (como edição de frequência, separação de mixagem, restauração de áudio e masterização) que levariam muito, muito mais tempo para serem executadas por operadores humanos altamente qualificados. O refinamento constante e as rotinas de aprendizado adaptativo permitem que os caminhos de software baseados em IA sejam aprimorados. Embora o termo ‘inteligência artificial’ seja normalmente atribuído a qualquer software que dependa de algoritmos para cumprir seus critérios, na verdade existe um amplo espectro de definições. Existem aqueles que simplesmente desencadeiam uma série de ações pré-determinadas que seus criadores criaram cuidadosamente e existem aqueles gênios virtuais semelhantes a HAL (iZotope RX 9 , Zynaptiq Adaptiverbpor exemplo) que pode inspecionar uma forma de onda, diagnosticar com precisão o que precisa ser feito para trazer mais clareza a ela.

Melissa Misicka, Diretora de Brand Marketing da iZotope, nos explica que usar a inteligência artificial para esse fim sempre foi uma ambição da empresa; “Um de nossos objetivos como empresa é encontrar maneiras de eliminar tarefas de produção de áudio mais demoradas para nossos usuários, para que eles possam se concentrar em sua visão criativa. Apresentar a tecnologia assistiva – que pode analisar seu áudio de forma inteligente e fornecer pontos de partida recomendados – pareceu uma maneira perfeita de fazer isso.”

Não se trata apenas de tornar os processos demorados mais rápidos. Muitos veem a IA como um método para realizar as tarefas que os humanos são incapazes de realizar. A iZotope explica como essa ideia foi colocada em prática. “Um exemplo é a separação de fontes para limpeza de fala.” Misicka nos diz: “Nossos módulos como Dialogue Isolate ou De-rustle dependem dele para atenuar sons indesejados como passos, chilrear de pássaros ou farfalhar de um microfone escondido nas roupas. O reparo manual desses ruídos seria muito trabalhoso, pois os ruídos mudam no tempo e se sobrepõem à fala”

“Outro exemplo é a síntese inteligente de sons de substituição.” Melissa continua: “Quando a fala vem de uma chamada telefônica, seu espectro de frequência fica limitado a 4 kHz, o que resulta em um som abafado característico. O módulo Spectral Recovery do RX usa aprendizado de máquina para recriar a banda de frequência superior ausente com conteúdo sintetizado realista para melhorar a qualidade da fala. As formas manuais de síntese de alta frequência incluiriam ferramentas como um excitador, mas a qualidade e a plausibilidade do conteúdo sintetizado não chegariam nem perto dos resultados do aprendizado da AI.

Sonible

A gama de plug-ins Sonible apresenta “ pure:comp ”, “ pure:verb ” e “ pure:limit ”, entre muitos outros. Projetados pensando nos criadores, esses plug-ins oferecem aprimoramento de som de nível profissional usando tecnologias de ponta. O conjunto de controle simplificado permite modelagem de som sem esforço, com opções poderosas para ajustar sua mixagem.

“ Pure:limit ” equilibra a dinâmica e encontra o nível perfeito para sua mixagem com apenas um toque de um botão. Enquanto isso, “ pure:comp ” e “ pure:verb ” oferecem processamento alimentado por IA e perfis característicos, parametrizando automaticamente para resultados de alta qualidade.

RoEx é uma plataforma da web onde produtores, músicos e podcasters podem enviar seu áudio, fornecer algumas configurações simples e obter um produto final polido e com som profissional em poucos minutos. A tecnologia inovadora cuida de todo o trabalho mundano, permitindo que você se concentre em ser criativo. Depois que a IA terminar de mixar, sua faixa estará pronta para distribuição imediatamente. Nenhum trabalho tedioso de pós-produção ou revisões intermináveis. Os serviços de mixagem AI também são fornecidos como uma API escalável e rápida. Isso significa que você pode integrar facilmente a tecnologia RoEx em seu fluxo de trabalho existente, permitindo otimizar ainda mais seu processo de produção.

Uma das aplicações mais benéficas da IA para músicos domésticos tem sido a rápida disponibilidade de serviços de masterização orientados por algoritmos. Tome LANDR por exemplo, o software perspicaz deste serviço de assinatura se apoia em uma mina de inteligência extraída de 20 milhões de faixas masterizadas. Ele usa essas informações para calcular como aplica o aumento de frequência personalizado e o brilho auditivo à sua música. “Quando o LANDR foi lançado pela primeira vez em 2014, era a primeira solução desse tipo para masterização de IA baseada em nuvem”. Patrick Bourget, Diretor de Produto da LANDR, nos conta. “Em 2016, o cenário começou a ver alternativas semelhantes, mas muito menos refinadas, surgindo no mercado.”

6 – Inteligência artificial vs Humanidade

Com a prevalência cotidiana de plataformas como LANDR, Patrick Bourget parece uma boa pessoa para perguntar sobre como ele vê essa dinâmica humano/máquina evoluindo no futuro, especificamente no domínio de masterização; “Dado o ritmo acelerado de criação e os orçamentos muitas vezes apertados dos produtores musicais em todo o mundo, sentimos que sempre haverá espaço para os engenheiros de masterização e masterização de IA “. Mas fora da masterização a sensação geral é que a IA veio para somar e não para substituir o processo humano na música e no áudio.

A iZotope ecoa este ponto fundamental, de que as aplicações de inteligência artificial mais bem-sucedidas até hoje são aquelas que ajudam criativos e profissionais a atingir seus objetivos, e não aquelas que buscam suplantá-los. “Muitas vezes imaginamos nossa tecnologia assistiva como, literalmente, um assistente de estúdio que pode dar o primeiro passo nos reparos ou fazer uma mixagem para você enquanto você toma um café.” Melissa explica: “Reforçamos que a missão das ferramentas de assistência da iZotope não é substituir a experiência profissional, mas treinar aqueles que ainda estão aprendendo, sugerindo os próximos passos, e ajudar aqueles que são mais experientes, levando-os a um ponto de partida. mais rapidamente.”

Embora seja indiscutível que a inteligência artificial continuará a penetrar em nossas vidas diárias em muitos níveis, é claramente aparente que, em vez de encolher diante de seu potencial insondável, músicos e produtores têm mais a ganhar do que perder com suas habilidades em constante desenvolvimento.

7 – As vantagens da mixagem e masterização com a IA

•Consistência: A mixagem e masterização AI podem ajudá-lo a garantir a consistência em várias faixas, fazendo com que soem como se estivessem juntas e também uma mix com mais transparência e definição.

•Economia de tempo: A mixagem e masterização AI podem economizar tempo automatizando todo o processo de masterização. Em vez de dominar manualmente cada faixa, as ferramentas de IA podem analisar e aprimorar várias faixas em questão de minutos.

•Custo-benefício: As ferramentas de mixagem e masterização de IA são muito mais baratas do que contratar um profissional. Elimina a necessidade de pagar pelo tempo de estúdio e pelos serviços de um engenheiro de mixagem/masterização.

•Acessibilidade: O software AI é acessível a todos, independentemente do nível de experiência em produção musical. O processo é simplificado e fácil de usar, permitindo que você se concentre nos aspectos criativos de sua música sem se prender aos detalhes técnicos.

8 – As desvantagens da mixagem e masterização com IA

•Masterização online instantânea: Landr, eMastered e AI Mastering:

Landr , eMastered e AI Mastering são serviços que dominam as faixas instantaneamente, e tudo o que você precisa fazer é carregar a faixa. É bastante barato, variando de $ 5 a $ 39 por mês, e é rápido. (Junte isso com sites lindamente projetados e você terá toda a atenção da geração do milênio). Existem alguns problemas com esses serviços: eles oferecem opções mínimas de edição e, simplesmente não soam tão bem quanto a masterização humana. Você está preso com a masterização que eles lhe dão, não há opções de ajuste fino disponíveis. Quando se trata de comparações lado a lado com o domínio humano, Landr e seus contemporâneos simplesmente não fazem o corte.

Resumindo: Landr, eMastered e AI Mastering são ótimos se você estiver com um orçamento apertado ou com pouco tempo, mas definitivamente não são suas melhores opções. Definitivamente sugeriria aprender a dominar suas próprias faixas ou enviar suas faixas para um profissional.

•Plug-ins híbridos AI/Manual: iZotope’s Neutron 3 Mixing Assistant e Ozone 9 Mastering Assistant:

As versões mais recentes do IZotope de seus aclamados plug-ins Neutron e Ozone agora incluem alguns elementos de IA. O Neutron 3 apresenta Mixing and Balance Assistant e o Ozone 9 agora possui um Mastering Assistant. Cada uma dessas ferramentas do Assistente ouve sua música em tempo real (ainda sem carregamento off-line) e equilibra, mixa ou masteriza sua música automaticamente. Cada um deles tem predefinições que você pode escolher e algumas maneiras de personalizar o resultado. Essas ferramentas são bastante úteis, mas não devem ser o fim de tudo.

Esses assistentes de mixagem e masterização funcionam bem como ponto de partida ou se você quiser apenas experimentar algo diferente. Os assistentes eliminam muito do trabalho pesado, mas ainda precisam de um ouvido treinado para obter o som certo. Além disso, posso definitivamente prever alguns casos em que tentar fazer com que o assistente de IA identifique os instrumentos corretamente pode dar mais trabalho do que vale a pena. No entanto, se você for seguir o caminho da IA, essas ferramentas são definitivamente o melhor caminho a percorrer.

Em resumo, o software de mixagem e masterização AI pode economizar tempo e dinheiro e isso é especialmente importante para produtores que estão apenas começando e têm recursos limitados. No entanto, existem algumas desvantagens reais na masterização que devem ser consideradas antes de entrar na onda da IA.

Aqui estão algumas vantagens da masterização manual analógica:

1 – Na masterização analógica: equipamentos de alta qualidade que irá incorporar sua assinatura sônica no seu áudio (mesmo sendo somente um summing).

2 – A experiência dedicada do profissional de anos de serviços técnico nessa área.

3 – Possível revisão com sugestões para a sua mix.

4 – Aquele toque humano final que dará mais vida e calor à sua música.

9 – IA e direitos autorais

Quem é o dono da música gerada por inteligência artificial? E se o software de IA pode ser inspirado por músicas existentes e gerar novas músicas de estilo semelhante, os direitos autorais se tornam uma área cinzenta?

Como toda nova área da tecnologia, a IA promete gerar muito trabalho para os advogados. Cliff Fluet, da empresa de consultoria de mídia Eleven, insiste: “Não é nada cinza. É que as pessoas não gostam de ouvir a resposta, dependendo do que estão fazendo. Mas você fez a pergunta-chave e há um monte de advogados especulando sobre isso! “Essa é uma pergunta tão boa ou tão ruim quanto perguntar quem é o dono de um filme. A verdadeira resposta é que depende de como você o fez, quanto é seu e quanto pertence a outra pessoa. Até que ponto você está recebendo informações de atores, cenógrafos, terceiros e assim por diante? Até que ponto você criou algo totalmente original? A resposta é tão simples e sofisticada quanto isso. Cada um depende de como seus processos, como seus algoritmos, como suas escolhas são feitas. Se você for um advogado realmente bom, a resposta é muito, muito simples, desde que você realmente entenda a profundidade dos processos. Dado que a IA para produção musical é uma tecnologia emergente, essa é uma área legalmente testada?

Cliff Fluet: “Eu diria que é e não é. A lei sobre direitos autorais de música foi construída sobre uma tecnologia altamente não confiável chamada músicos e o cérebro humano. Você tem pessoas perguntando ‘E se uma máquina replicar outra coisa?’ – e é como ‘Bem, e se um artista replicar outra coisa?’, que é o que acontece todos os dias na indústria da música. Há perguntas reais sobre alguém realmente ouviu algo ou não? Alguém realmente adaptou algo? A lei não é diferente quando se trata de uma máquina ou de um ser humano. A diferença entre um ser humano e uma máquina é que com uma máquina você tem provas absolutas.”

Cliff aponta para casos legais anteriores em que “o júri tem que sentar e tentar descobrir se alguém ouviu algo, adaptou algo ou fez. Com uma máquina, você não precisa confiar em sua memória, você literalmente pode ver todas as notas lá, então, na verdade, acho que é mais fácil do que mais difícil. Descobrir se um humano roubou ou não uma composição ou se é dono ou não, ou se a compartilhou ou não, é muito, muito mais complexo do que uma máquina. No mínimo, os avanços na tecnologia podem ajudar.”

10 – O futuro da música com a IA

É provável que o futuro veja uma explosão de novas músicas criadas por pessoas que antes não tinham meios para fazê-lo, habilitadas por ferramentas baseadas em IA. Da mesma forma, músicos e produtores provavelmente encontrarão mais tempo para serem criativos e criar músicas de novas maneiras, deixando a IA para gerenciar tarefas funcionais repetitivas. É provável que a criação de música se torne parte das interações online das pessoas, com os consumidores criando e compartilhando novas músicas por meio de plataformas de mídia social.

A IA para produção e consumo de música é uma área enorme, e este artigo só pode oferecer uma amostra da pesquisa e desenvolvimento contínuos para serviços de música de IA. Como diz Cliff Fluet, “IA vai se tornar um termo tão útil quanto falar sobre ‘a Internet’. Vinte anos atrás, se eu tentasse descrever a Internet, você pensaria que era apenas uma plataforma – e na verdade foi o primeiro passo para algo enorme.”

As ricas oportunidades em torno da IA levantam muitas questões e, até o momento, temos apenas algumas respostas. Muitos desenvolvimentos estão em sua infância e alguns timings permanecem incertos. O que é certo é que a IA estar recebendo muita atenção de grandes gravadoras, artistas número um, incubadoras de negócios e desenvolvedores de software de ponta, então as mudanças estão a caminho. Muitos colaboradores estimam que veremos uma mudança na produção e consumo de música nos próximos cinco a sete anos. A adoção generalizada se reduzirá à facilidade com que podemos interagir com nossas ferramentas de IA e à qualidade dos resultados finais, que estão avançando constantemente. Como acontece com qualquer tecnologia emergente, temos claramente a opção de usá-la e como queremos usá-la, e pode ser o mercado que molda a direção do software de IA. Todos os nossos colaboradores fizeram questão de enfatizar que a IA não substituirá artistas ou produtores. Paradoxalmente, quanto mais usamos IA na música, mais podemos aproximar as pessoas.

Pascal Pilon, da LANDR

Aponta que “a indústria da música é retardatária em muitos aspectos. Veja o mercado financeiro e como start-ups em todo o mundo estão buscando financiamento para desenvolver e comercializar produtos com a ajuda de parceiros de capital de risco. Na indústria da música, esse papel tem sido historicamente desempenhado pela gravadora, mas fechar um acordo com as gravadoras ainda é muito rudimentar. Acho que o modelo de financiamento da indústria da música se tornará cada vez mais baseado em dados, mais competitivo. Isso atrairá mais capital de um conjunto mais amplo de investidores, ainda envolvendo gravadoras, mas também um conjunto maior de pequenos a grandes investidores anjos”.

Pascal prevê que as gravadoras ainda precisarão investir pesadamente em talentos para promover a música. “Mesmo que haja IA, você ainda precisará de pessoas para trazer visibilidade aos artistas. Pense em marketing: a coisa mais rara que você consegue são ouvintes no espaço musical que gastam. Sua capacidade de levar as pessoas a ouvi-lo ainda exigirá um elenco de colaboradores do ponto de vista do marketing. Novamente, é muito semelhante à indústria cinematográfica. Veja como o orçamento de produção é importante – sim, eles são enormes, mas pense no orçamento comercial, que é ainda maior. Para chamar a atenção das pessoas, você precisará gastar em canais para entregar isso – pense no Facebook. Se você puder trazer viralidade para empresas como o Google e o YouTube, poderá ser independente, mas isso exigirá muita sofisticação do ponto de vista da promoção.”

11 – Considerações finais

A inevitável integração cada vez mais ampla da Inteligência Artificial no campo da produção musical aponta para uma era de transformações iminentes, estamos diante da necessidade de nos prepararmos para esta revolução por meio de estudos, pesquisas e capacitação, a fim de otimizar sua aplicação. É crucial enfatizar que esse processo está intrinsecamente ligado a elementos como plugins, aplicativos e DAWs, os quais imprimem sua qualidade sônica ao resultado final, e principalmente no contexto da masterização assistida por IA, a excelência do desfecho dependerá diretamente da qualidade do software empregado e do seu uso da forma correta.

Do meu ponto de vista (Marlon Porto) é inegável que, até o momento, a qualidade sonora proporcionada por compressores, equalizadores, processadores e conversores especializados em masterização predominantemente analógicos, permanecem insuperáveis com resultados diferenciados, seguindo assim o padrão da indústria fonográfica.

Já na restauração; os softwares dedicados são insuperáveis com suas IAs. Na esfera da mixagem, embora o impacto seja menor até agora, é imperativo que as startups também reconheçam essa preocupação, pois a qualidade e autenticidade sônica desempenham um papel importante, além disso, o algoritmo subjacente ao modelo de IA deve desempenhar um papel crucial na otimização do processo, porém sem comprometer outros elementos da mixagem, é crucial adotar uma abordagem consciente no uso destas tecnologias em evolução, pois enfrentamos um horizonte promissor, porém desafiador e uma mistura dos dois mundos é o recomendado até o momento.

*Autor: Marlon Porto é técnico de áudio da Promaster studio

Fontes de pesquisas e recortes:

- https://watt-ai.github.io/blog/music_ai_evolution

- https://en.wikipedia.org/wiki/Music_and_artificial_intelligence

- https://www.musicradar.com/news/the-history-of-ai-in-music-production

- https://audiomediainternational.com/artificial-intelligence-in-music/

- https://www.soundelicit.com/disadvantages-of-ai-mixing-and-mastering/

- https://www.lalal.ai/blog/best-ai-mixing-mastering-tools/

- https://www.soundonsound.com/music-business/ai-music

Tutorial áudio

Tutorial – Uma nova maneira de gravar locução

Publicado

4 anos agoon

23/03/2022Por

Fran Carbone

Uma das partes fundamentais da pós – produção de áudio é a produção das locuções. Elas estão presentes em filmes, vídeos institucionais para publicidade, dublagens e audiolivros.

Basicamente o processo de produção de locuções é o mesmo para qualquer instrumento, onde primeiramente ocorre a gravação dos áudios, edição e mixagem. A gravação normalmente requer bastante atenção e expertise do engenheiro, pois é nessa etapa que se garante a qualidade sonora. Engenheiros com mais experiência conseguem fazer o processo da mixagem junto com a gravação. Sem dúvida o processo mais demorado é o da edição, que consiste em compilar os melhores takes gravados e formar o áudio final. Isso requer muita organização para que tudo flua com rapidez e qualidade.

O processo tradicional

No processo tradicional de produção, o locutor narra o texto de uma só vez, garantindo a fluidez e o ritmo do texto. Quando acontece algum erro ele regrava do ponto que parou e segue gravando o texto seguinte. Dá para imaginar que ao final de uma gravação de um texto de 10 minutos, temos um áudio bruto de 30 minutos ou mais. Após a gravação, o engenheiro pacientemente tem que ouvir todos os trechos novamente e escolher o melhor deles. Essa escolha é feita arrastando os melhores takes para uma track de áudio abaixo da original.

Um pouco tedioso, não? Além de demorado.

Uma nova abordagem

Pensando em otimizar o tempo, desenvolvi uma outra maneira de trabalhar com edições de locuções que me permitiu ter o áudio final no mesmo instante que o locutor acaba de gravar. Essa nova maneira de pensar está presente no meu curso online de Pro Tools e hoje quero te mostrar como é fácil e super ágil.

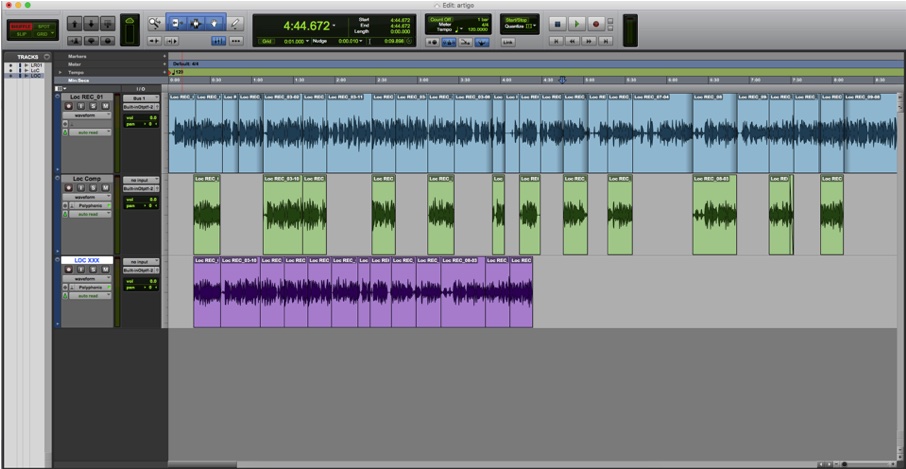

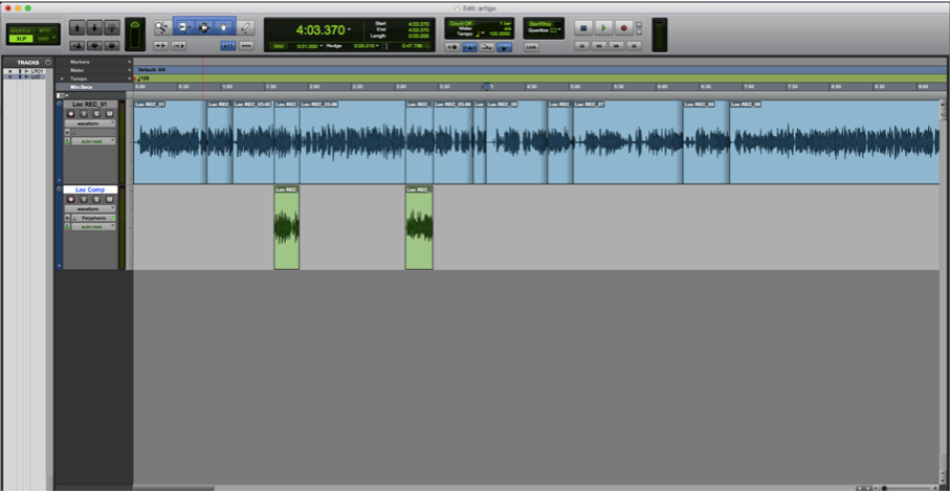

Primeiramente, criamos três tracks de áudio. A primeira track será para gravar, a segunda para guardar os melhores takes e a terceira para juntar os melhores pedaços e formar o áudio final.

O grande truque vem agora. O locutor dificilmente gravará o texto sem nenhuma interrupção. Com certeza ela irá parar por conta de um erro ou mesmo falta de fôlego. Assim que ele interromper, pare a gravação com a barra de espaço e imediatamente coloque o cursor do Pro Tools um pouco para frente. Comece a gravação novamente. A grande vantagem é que enquanto ele grava o trecho seguinte, você pode ir arrastando para baixo o melhor trecho anterior que foi gravado. Se você estiver trabalhando junto com um diretor de locução fica ainda mais fácil, pois ele pode falar para você qual foi o melhor trecho que ouviu anteriormente.

Enquanto o áudio da frente é gravado, coloque os melhores takes anteriores na track de baixo

Depois de terminada a gravação, você já estará com os melhores takes selecionados. Agora basta formar o áudio final. Arraste todos eles para a última track e pronto! Sua locução final está montada. Pra ficar ainda mais fácil, ative o modo shuffle do Pro Tools para que os áudio “colem” nas bordas uns dos outros.

Agora você pode fazer um ajuste fino em cada corte, colocar um fade e começar a mixar!

Tutorial áudio

Vídeo: Qual a importância do summing analógico no processo das masterizações musicais?

Publicado

4 anos agoon

17/01/2022Por

Marlon Porto

Qual a importância do summing analógico profissional em suas músicas durante o processo de masterização.

Com a maior conectividade das plataformas digitais e a execução on-line ou para download de áudios com taxas de amostragem mais altas, abriu-se espaço para masterizações na versão HI-FI, e nesse vídeo explico que o processo do summing analógico é uma excelente opção para adquirir mais qualidade em sua música por conseguinte a exceção em sistemas de streamings HI-FI ou em sistemas de sons tambem em HI-FI.

Áudio

Manutenção preventiva de sistemas de PA e line array

Checklist prático para integradores e técnicos prolongarem a vida útil e evitarem falhas em campo. Sistemas de PA e line...

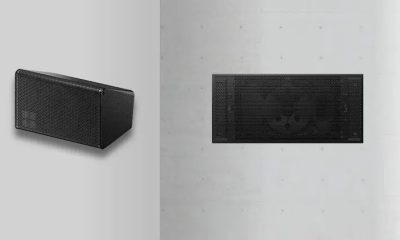

d&b audiotechnik apresenta caixa compacta 42S para espaços exigentes

Novo modelo da Série xS combina tamanho reduzido, controle de dispersão e versatilidade de instalação. A d&b audiotechnik ampliou sua...

Espanha: Amnesia Ibiza atualiza sistema de som com KV2 Audio

Projeto adapta o áudio da pista Terrace para sessões longas e diferentes zonas do clube. O clube Amnesia Ibiza realizou...

Cadac nomeia Proactive Solutions LATAM como distribuidora para América Latina e Caribe

Parceria leva o ecossistema de mixagem ao vivo CM-system para a região e reforça estratégia de expansão internacional. A Cadac...

Espanha: Equipson adquire a Musicson e reforça produção de áudio profissional

O Equipson Group anunciou a aquisição da Musicson, fabricante de alto-falantes e soluções de áudio profissional fundada em 1965 e...

Leia também

Iniciativa inspirada em Villa-Lobos leva concertos gratuitos a escolas públicas de SP

Brasil de Tuhu une educação, cultura e inclusão; em agosto, passa por cidades da Grande São Paulo e interior. A...

Teatro Opus Città anuncia inauguração com atrações nacionais e internacionais

Espaço cultural na Barra da Tijuca funcionará em soft opening ao longo de 2025 e terá capacidade para até 3...

Harmonias Paulistas: Série documental exalta grandes instrumentistas de SP e homenageia Tom Jobim

A música instrumental paulista ganha um novo espaço com a estreia da série Harmonias Paulistas, produzida pela Borandá Produções e...

Falece o reconhecido baterista Dudu Portes

O mundo musical despede Dudu Portes, deixando sua marca no mundo da percussão. Nascido em 1948, Eduardo Portes de Souza,...

Música transforma vidas de presos em projeto de ressocialização

A ressocialização de detentos no Brasil tem ganhado novas dimensões com projetos que unem capacitação profissional e arte. Iniciativas como...

Paraíba: Editais do ‘ICMS Cultural’ incluem projeto para estudar música

Edital do Programa de Inclusão Através da Música e das Artes (Prima) planeja oferecer 392 vagas para jovens paraibanos que...

Academia Jovem Orquestra Ouro Preto abre vagas para 2024

Criado para promover o ensino da prática orquestral, projeto abre edital para jovens músicos. As inscrições vão até 20 de...

Conselho Federal da OMB emite nota de repúdio ao Prefeito de Maceió. Entenda.

Desrespeito à legislação local acende debate sobre valorização da cultura alagoana. O conflito entre a classe artística de Maceió e...

Quem Canta Seus Males Espanta: Sandra Sofiati e seu Corpo Sonoro

Nesse novo artigo de Quem Canta Seus Males Espanta, vamos sair um pouco dos instrumentos “externos”, e nos voltar para...

Talibã Queima Instrumentos Musicais no Afeganistão

Centenas de músicos fugiram do Afeganistão para escapar das restrições do Talibã à música, afetando a cultura musical O Talibã,...

Maestro Evandro Matté fala sobre o Multipalco

À frente de três orquestras, a do próprio Theatro São Pedro, e da Orquestra Jovem, fruto de um projeto social,...

Multipalco: Viagem ao centro da arte

Música & Mercado foi ao centro da capital gaúcha visitar a história cultural do Rio Grande do Sul em uma...

Como obter patrocínio de 100 mil ou mais para realizar seu projeto de música

Adriana Sanchez mostra como obter patrocínio de 100 mil ou mais para realizar seu projeto de música. Criadora da banda...

Exportação de música brasileira, uma boa ideia!

O Brasil possui uma série de dificuldades na exportação de sua música para uma audiência internacional, mesmo assim, exportar é...

Presidente da Anafima recebe medalha de reconhecimento cultural do Governo de SP

Daniel Neves recebeu a honraria durante o Prêmio Governo do Estado de São Paulo para as Artes 2022, na noite...

Retomada de eventos em 2021 recuperou 300 mil postos de trabalho, sem recuperar nível de emprego de 2019

Retomada de eventos em 2021 recuperou 300 mil postos de trabalho, sem recuperar nível de emprego de 2019. A evolução...

OneBeat Virtual: inscrições de intercâmbio virtual para músicos

Embaixada e Consulados dos EUA abrem inscrições de intercâmbio virtual para músicos até 11 de fevereiro O OneBeat Virtual busca...

Manual de procedimentos do profissional da música

Guia básico sobre conceitos que os profissionais da música deveriam aplicar nas suas carreiras e no trato com outros no...

Câmara Setorial de Instrumentos Musicais do Paraná visita presidente da câmara Municipal de Curitiba

Yuris Tomsons, destacado pela Associação Comercial do Paraná para fazer a interlocução com os presidentes das comissões permanentes da Câmara...

Make Music: Robertinho Silva, Milton Nascimento e João Donato recebem homenagem no evento

Homenagem a Robertinho Silva, Milton Nascimento e João Donato: produção convida músicos de todo o Brasil para participar. Saiba como...

Presidente Prudente inaugura espaço dedicado a bandas de garagem

Espaço Garagem em Presidente Prudente contou com o apoio da loja Audiotech Music Store Presidente Prudente/SP – O prefeito Ed...

Música & Mercado apoia campanha em favor de artistas impactados pela pandemia

Idealizada e promovida pela Beetools, iniciativa destinará 25% da receita líquida das matrículas nos cursos da startup para garantir uma...

Governo anuncia liberação de R$ 408 milhões em recursos para o setor de eventos

Secretaria Especial da Cultura afirma que auxílio deve ficar disponível ainda no primeiro semestre. Na última terça-feira (9), o governo...

Brasileiro promove boa saúde entre músicos

Empresário brasileiro promove boa saúde entre músicos. Marcos Mendes, empresário, investidor no ramo de nutracêuticos, é um constante apoiador na...

Opinião: Música é agente de mudança

Arte não é algo que seja isento de ideologia, porque o pensamento e o sentimento são suas bases enquanto materia-prima....

Opinião: Me lembro como se fosse hoje

O mercado da música está passando por diversas mudanças, mas também está mudando o consumidor e o músico, com uma...

Opinião: É tempo de aprender… Música!

E lá se vai 1/3 do ano trancado em casa. Desde março, pais que trabalham, filhos que estudam, todos se...

Saúde: Automotivação no mercado da música

Todos nós fazemos música, e realizamos sonhos. Nunca se esqueça disso! Você sabe o que significa a palavra motivação? O...

Música para quem vive de música – Volume 14

Continuamos apresentando grandes discos e filmes para sua cultura musical. Hoje temos Def Leppard, Sonny Rollins e Plebe Rude. Def...

Fernando Vieira: O amor à música como legado

Jornalista Fernando Vieira faleceu e deixou um imenso legado. Cabe a todos manterem a chama da música acesa. A morte...

Trending

-

Audio Profissional4 semanas ago

Audio Profissional4 semanas agoMultilaser compra operação da Sennheiser no Brasil em aposta de R$ milhões no mercado de áudio profissional

-

Guitarra4 semanas ago

Guitarra4 semanas agoBenson Instrumentos apresenta linha de guitarras Brave Series

-

Instrumentos Musicais4 semanas ago

Instrumentos Musicais4 semanas agoO uso do órgão Hammond no Brasil

-

Artigos3 dias ago

Artigos3 dias agoVibro Sensory Musical — quando a música também é sentida

-

Instrumentos Musicais3 semanas ago

Instrumentos Musicais3 semanas agoDo Brasil para o mundo: a Hernan Voyzuk Project Series entra no catálogo global da Bosphorus

-

NAMM Show4 semanas ago

NAMM Show4 semanas agoNAMM 2026: Kepma apresenta a F2S Lamplight, novo acústico-eletroacústico Grand Auditorium

-

NAMM Show4 semanas ago

NAMM Show4 semanas agoNAMM 2026: Martin renova a Road Series e apresenta 20 modelos

-

Amplificadores4 semanas ago

Amplificadores4 semanas agoNAMM 2026: VOX apresenta os novos AC15 e AC30 Hand-Wired Greenback