Tutorial áudio

Como montar seu home studio – Capítulo XII

DAWs – Síntese para leigos no Studio One. Conheça o software e como funciona.

-32 vozes com oversampling (conversão de analógico para digital) de até 8 x

-2 osciladores (ondas senoidais, triângulares, dente-de-serra e quadradas)

-Controles de largura do oscilador, sincronismo, PWN (modulação da largura do pulso) e fase aleatória

-Gerador de ruído

-Processador de “caráter”

-Filtros multi-modo, progressivo, de delay, passa-baixas, passa-banda e passa-altas

-2 LFO (osciladores de frequência baixa)

-3 envelopes ADSR (Ataque, Decaimento, Sustentação e Retirada)

-Matriz de modulação com 16 slots

-Efeitos: Chorus, Flanger, Phaser, Delay, Reverb, Gater, EQ, Distorção e Pan

Interface

O painel de controle central contém os 2 osciladores (1 e 2) e o gerador de ruído, o processador de caráter e filtros, os LFO e os geradores de envelope. Estes são os controles básicos para esculpir o som. Você pode habilitar ou não cada um deles clicando no seu nome. À direita destes controles estão os parâmetros (Global) que lhe permitem ajustar o comportamento geral e a capacidade do sintetizador para o que você quiser.

Na parte de baixo da janela está a seção de efeitos FX, que permite o acesso à matriz de modulação e efeitos, e os botões imitando um teclado.

Osciladores

O botão de Bypass liga ou desliga cada oscilador. Isso permite que você crie sons de um só oscilador, ou desligar um deles temporariamente, para se concentrar no que fazer com o outro.

Os 4 formatos de onda: senoidal (Sine), triangular (Triangle), dente-de-serra (Sawtooth) ou quadrada (Square)

O PWM só funciona com as ondas quadradas, e permite variar a sua largura do pulso de onda, mudando a distribuição dos harmônicos, e assim o seu tom.

Octave – controla a faixa de frequência, em oitavas, de cada oscilador. Essa faixa está medida em pés (medida norte-americana) como nos tubos de um órgão de tubos, logo, quanto menor o valor mais agudo será o som.

Random Phase – ajusta o oscilador para fase aleatória, no que, quando uma nota é tocada, o oscilador começa a forma de onda num ponto inicial. Isso estabelece uma relação de variação de fase entre os dois osciladores (quando estão os 2 ligados) sempre que uma nota é tocada, criando mudanças interessantes no som ao longo do tempo. Desligando essa função a forma de onda começa quando uma nota é tocada, melhor para os sons de percussão, que precisam de um ataque uniforme, de nota para nota.

Semi e Fine – ajustam a altura do oscilador em Semitons (Semi) ou centésimos (Fine)

Spread – (só no oscilador 1) cria camadas adicionais que seguem a altura do oscilador com quantidades crescentes de desafinação à medida que mais camadas de osciladores são misturados. Isso cria um som mais encorpado. Se girar o Spread todo para a esquerda, vai ouvir só um oscilador, e para a direita vai adicionando osciladores, com maior distorção e estéreo.

Sync – (só no oscilador 2) recomeça a forma de onda do oscilador 2 a cada vez que o oscilador 1 repete. É uma técnica clássica de sintetizador analógico, criando harmônicos ricos e som mais estridente. E esse som é expandido mais ainda quando a modulação de altura é aplicada a um ou a ambos os osciladores com o LFO ou o envelope.

Sub – cada um dos osciladores tem um sub-oscilador de onda senoidal anexado, que toca a mesma altura o oscilador principal, mas uma oitava abaixo. Este controle permite misturar o sinal do sub-oscilador para tornar o som mais grosso, sem precisar usar para isso um segundo oscilador principal.

Level – permite regular o volume de cada oscilador

Pan – separa cada oscilador para a esquerda ou direita

Noise Generator

Noise Generator

A seção do gerador de ruído acrescenta texturas e características aos sons, com os seguintes controles:

Bypass – liga e desliga o ruído

Level – volume do gerador de ruído

Pan – posiciona cada oscilador no estéreo

Color – muda o timbre do ruído do escuro para o brilhante

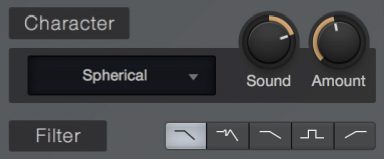

Character

Bypass – Clique no botão Character para ligar e desligar

Mode Menu – Escolha diferentes modos de processamento espectral e de formantes.

◦ Analog Color – Esses modos de características simulam uma variedade de circuitos analógicos de áudio. Nestes modos, o botão Sound mistura entre 2 circuitos diferentes, com efeitos também diferentes no som.

▪ Ardency

▪ Bassmoderator

▪ GrandClass

◦ Formant – Esses modos de características afetam o som usando técnicas de formantes, e neles o botão Sound alterna através de várias formantes.

▪ CharacterSaw

▪ Subvox

▪ Talky

▪ Voxil

◦ Harmonics – Essas características de modos geram harmônicos e efeitos de espectro, e neles o botão Sound alterna entre a extensão dos harmônicos.

▪ Ampog

▪ Fuzzarmonics

▪ Harmonia

▪ Harmson

▪ Spherical

▪ Subharmonium

Sound – Deixa você variar o efeito do processador de características. Cada modo de caracteríticas responde a esse controle de uma maneira individual, então experimente.

Amount – Deixa você misturar o sinal puro e o sinal do processador de características.

Filter

Filter

O Mai Tai oferece um filtro versátil, que lhe permite modelar e aprimorar seus sons. O filtro é de longe um dos elementos mais importantes e definidores do som de um sintetizador que usa a síntese subtrativa, e por isso as características únicas deste filtro tˆm muito a haver com o som do Mai Tai, e oferece os seguintes controles:

• Bypass – botão que liga e desliga o filtro.

• Filter Mode – Escolha entre os seguintes modos de filtrar, cada um com suas características:

◦ LP 24dB Ladder – Simula o clássico filtro passa-baixas frequências com 24 decibéis por oitava, baseado na configuração de transistor dos sintetizadores clássicos. Este tipo de filtro deixa passar as frequências abaixo da faixa de corte escolhida, cortando as frequências acima da faixa de corte escolhida, com uma taxa de 24 dB por oitava.

◦ LP 24dB Zero – Este é outro filtro passa-baixas frequências, baseado numa arquitetura de delay zero que modela o comportamento dos tons de filtros analógicos.

◦ LP 12dB Ladder – Mais um filtro passa-baixas, mas com uma curva de 12 decibéis por oitava, que corta as frequências de forma menos agressiva do que os de 24 dB.

◦ BP 12db Ladder – Este é um filtro de passa-baixas e passa-altas frequências, conhecido como filtro passa-bandas de frequências. Com ele se pode selecionar uma faixa de frequências que vão passar, e daí ele corta essas frequências acima e abaixo dos valores escolhidos, com uma taxa de 12 decibéis por oitava.

◦ HP 12dB Ladder – Filtro de passa-altas frequências com 12 dB por oitava, que deixa passar as frequências acima da faixa de corte, e cortando as frequências abaixo do valor escolhido com uma taxa de 12 dB por oitava.

• CutoffT- permite configurar a frequência de corte do filtro – o ponto de filtragem na qual é cortado em 3 db o sinal de entrada. No caso do filtro passa-bandas, este ponto configura o ponto central, médio das frequências que vão passar.

• Soft – Esse controle permite você alternar entre 2 diferentes processamentos de circuito analógico do filtro: Engage Soft para um tom mais escuro, menos melódico, e Disengage para um som mais brilhante e agressivo.

• Drive – Controle que permite especificar uma quantidade de saturação, para acrescentar elementos que engordam o som.

◦ Punch – Este controle permite adicionar uma extensão de ataque percussivo no início de cada nota. No ajuste mínimo, a dinâmica não muda nada. Nos ajustes maiores, o som se torna mais agressivo e aparece mais na mixagem do som.

◦ Resonance (Res) – Este controle permite configurar a quantidade de ressonância do filtro, que consiste em um foco centrado na frequência de corte. Nas configurações mais baixas o filtro corta as frequências mais suavemente. À medida em que se aumenta a Res (ressonância), o corte de frequências fica mais acentuado, capaz de imitar ressonâncias como vozes e instrumentos acústicos, além de efeitos de sintetizador clássicos. Nas configurações mais altas, o filtro pode oscila por si mesmo, emitindo um tom na frequência de corte configurada. E essa oscilação do filtro pode servir como um osciladora a mais, principalmente se usado em conjunto com o parâmetro Key.

▪ Velocity (Vel) – Controle que regula a relação entre a intensidade da entrada voz (Voice Velocity) e o corte do filtro. Girando para a direita, o corte aumenta à medida que a intensidade da nota aumenta. Pra esquerda o ponto de corte diminui à medida que a intensidade da nota aumenta.

▪ Key – Controle que regula a relação entre a intensidade da entrada da altura da voz (Voice Pitch) e o filtro. Nos instrumentos reais, notas mais altas tendem a produzir harmônicos mais agudos, que brilham aos poucos à medida em que se sobe de altura na escala. Já em um instrumento sintetizado, se o filtro fica parado, configurar o tom apropriado nas notas mais baixas pode causar uma diminuição ruim na notas mais altas. Com o parâmetro Key se pode compensar isso e se criar timbres mais naturais para o grave ou agudo no teclado.

◦ Quando o Key está virado todo para a esquerda, o filtro não se altera pela altura da nota. No meio, o corte segue as notas de modo discreto, permitindo que as mais altas ganhem brilho. Virado totalmente pra direita o corte segue a altura da nota para cima e para baixo na altura em valores de meios-tons como as notas são recebidas. O que permite que o filtro seja usado como um oscilador ou ressonador acústico tradicional.

LFO 1 and LFO 2

LFO 1 and LFO 2

LFO é a sigla Low Frequency Oscillator – Oscilador de Baixa Frequência – que funcionam parecidos com os osciladores 1 e 2 do Mai Tai, só que mais lentos. Os osciladores normais são usados principalmente para criar alturas acústicas audíveis, enquanto os LFO criam ciclos regulares do movimento lento de controle do sinal que são úteis para regular outros parâmetros ao longo do tempo. Um exemplo comum disto é como os timbres de sintetizador respondem quando se move o controle de “rodinha” – Wheel – pra cima a partir do zero. O som dos osciladores aumenta ou diminui muito, bem como o som do vibrato. Isso é apenas um movimento de modulação do oscilador LFO por degraus configurados pela posição da rodinha. Os LFO 1 e 2, ambos, têm controles idênticos:

• Bypass – Liga e desliga cada um.

• LFO Type – Escolha entre formatos de onda senoidal (Sine), triangular (Triangle), dente-de-serra (Sawtooth), quadrada (Square) e Sample&Hold, para o oscilador do LFO.

◦ Rate – Este controle permite configurar a taxa em que o LFO oscila, desde a quase inaudível (0,01 Hz), para longas mudanças, até intervalos mais altos (até 8kHz), úteis para técnicas de FM (frequência modulada). Quando o botão Sync está ativado, a taxa pode ser definida em valores de tempo da música, como notas de meio-tempo ou 1 tempo.

◦ Sync – Ative esta opção para configurar a taxa do LFO em valores de duração de nota (de 1/2 ou 1 tempo) com relação ao tempo da música. Desative para configurar em Hertz (Hz).

◦ Key – Ative esta opção para associar o andamento (tempo) do LFO à altura da nota recebida. Notas mais altas vão soar com andamento do LFO mais altos, e as mais baixas com andamentos mais baixos.

◦ Free – Ative esta opção para executar o LFO seguidamente, com os inícios do LFO diferentes para cada nota tocada. Desative para reiniciar o formato de onda desde o início de cada nota.

▪ Delay – Este controle permite especificar uma quantidade de tempo em milésimos de segundo para o LFO esperar antes de ser ativado depois que uma nota for tocada. Isso permite efeitos como adicionar um pouco mais de expressão às notas mantidas soando, ou criar camadas de modulação que começam em momentos diferentes para cada nota, definindo valores de delay diferentes para cada LFO.

Envelopes

Envelopes

Geradores de Envelope são partes vitais da síntese sonora, nos dando a habilidade de modelar a amplitude e o timbre de nossos sons com o tempo e escala de cada nota. O Mai Tai tem 3 geradores de envelope, rotulados de Amp Env (assim chamado porque totalmente dedicado para a amplitude), Env 2 (quase sempre designado para corte de filtros, na modelagem dos timbres), e Env 3. Todos os três são disparados quando uma nota é tocada. Cada saída dos envelopes gera um sinal que segue os controles:

• Attack (A) Ataque – Controle que permite configurar o tempo requerido para o envelope ir de zero (silêncio) até a amplitude máxima, num alcance de 0 ms (milésimos de segundo) até 20 segundos.

• Decay (D) Decaimento – Controle que permite configurar o tempo requerido para cair da amplitude máxima para a Sustentação (S) num alcance de 0 ms a 20 s.

• Sustain (S) Sustentação – Controle que permite configurar o nível do sinal que será mantido a partir do final do Decaimento (D) até que tecla da nota tocada seja solta, num alcance de -∞ dB (- infinito = silêncio) até 0.0 db (máxima amplitude).

• Release (R) Retirada – Controle que permite configurar o tempo requerido até atingir o silêncio depois que a tecla é solta, num alcance de 0 ms até 30 segundos.◦ Delay (só nos Env 2 e 3) Este controle permite especificar uma duração de tempo em milésimos de segundo para o envelope pausar antes de começar sua fase de ataque depois que uma nota é tocada. Isso pode ajudar na criação de sons envolventes, nos quais ciclos de modulação ocorrem em tempos diferentes ao longo da duração de uma nota.

Display Gráfico do Envelope

Cada envelope possui uma exibição gráfica correspondente que representa a forma criada pelas configurações de seus parâmetros. Existem pontos e alças nos cantos e curvas de cada envelope que você pode clicar e arrastar, permitindo que se dê forma ao envelope ADSR e a curva entre seus pontos, visualmente. Se você deseja alongar qualquer fase do envelope além dos limites de tempo da exibição atual, basta arrastar o ponto para a direita do gráfico e a escala de tempo se ajusta para exibir corretamente a nova configuração.

Global Settings

Global Settings

As configurações globais (Global Settings) a seguir permitem configurar o comportamento geral e capacidades do Mai Tai para alcançar suas necessidades.

• Volume – Controla o volume de saída, num alcance de -∞ dB (silêncio) até +6.0 dB (6 dB acima da unidade de ganho).

• Velocity – Configura a graduação com que o volume do Mai Tai é afetado pela intensidade (força), de zero (sem sensibilidade à força) até 100% (máxima sensibilidade à força) com que a nota é tocada.

• Poly, Mono, and Glide – Poly habilita o modo polifônico para permitir execuções polifônicas (mais de uma nota ao mesmo tempo). Mono para tocar só uma nota por vez. No modo Mono, você pode habilitar Glide para “puxar” uma altura suavemente de uma nota à outra, o chamado legato (uma nota tocada enquanto a anterior ainda está soando). O botão Glide permite configurar o alcance da mudança de altura de 1 ms até 1 segundo.

◦ Voices – Regula o nível de polifonia (número de vozes que podem soar ao mesmo tempo) do Mai Tai, num alcance de 1 a 32 vozes. Veja que este controle não funciona no modo Mono, obviamente.

◦ Quality – Escolha entre uma variedade de modos de qualidades de som que sejam adequados ao poder do processador de seu computador e seu gosto musical na produção dos timbres. Eis os modos disponíveis:

◦ 80s – O mais simples e eficiente dos modos. A modulação de alta frequência pode criar padrões mais rígidos, mais tipicamente “digitais” neste modo, como em alguns sintetizadores digitais do início dos anos 80.

◦ Normal – O modo padrão, combina bem o uso do processador com a complexidade do som criado. É adequado nas tarefas mais comuns do sintetizador.

◦ High – Esse modo vai consumir mais poder de processamento para lidar com a modulação de alta frequência, como a usada na síntese FM.

◦ Supreme – Este modo possibilita a simulação mais realista da síntese analógica, rica e complexa. O uso do processamento será alto, mas os resultados podem compensar.

Effects

O Mai Tai oferece 7 processadores de efeitos para adcionar dimensões aos seus sons. Eles estão organizados em 2 bancos: FX A (Modulation, Delay e Reverb) e FX B (Gater, Equalizador, Distortion e Pan). Você pode habilitar ou desabilitar cada efeito clicando no seu nome. E pode mostrar ou esconder a janela da seção Mod/FX clicando no botão Mod/FX.

Modulation

Este processador cria efeitos baseados no tempo. Escolha entre eles clicando nos botões

[Chorus], [Flanger], ou [Phaser]:

• Chorus – Processador que cria efeitos parecidos a vários instrumentos iguais tocando a mesma coisa ao mesmo tempo. O sinal do sintetizador passa por uma modulação de atraso curta, que é mixada com o sinal de entrada sem efeito. Tem os seguintes controles:

◦ Mono – Ative esta opção para somar o sinal com efeito ao sinal monofônico.

◦ Delay – Permite configurar o comprimento da modulação do atraso. Configurações mais altas criam efeitos mais encorpados, enquanto configurações mais baixas criam harmônicos mais nítidos, mais parecidos com um Flanger.

◦ Speed – Configura a velocidade com que cada linha de atraso é modulada. Ajustes mais baixos criam efeitos mais lentos, e os mais altos soam mais rápidos e agressivos.

◦ Width – Ajusta a graduação com a qual a linha de atraso é modulada. Ajustes baixos produzem efeitos de chorus mais sutis, e os mais altos produzem mudanças mais acentuadas no timbre ao longo do tempo.

◦ Depth – Mistura o sinal de entrada sem efeito (virado todo para a esquerda) com o sinal processado (virado todo para a direita).

• Flanger – Processador que cria efeitos de varredura ressonantes e ocultos. O sinal de sintetizador é alimentado através de um atraso curto e modulado, que é misturado com o sinal sem efeito. Embora semelhante ao funcionamento de um Chorus, o Flanger obtém o seu som empregando tempos de atraso menores do que aqueles usados no Chorus, combinados com um sistema de realimentação que pode adicionar ressonância à varredura. Tem os seguintes controles:

◦ Mono – Ative essa opção para misturar o sinal com efeito ao de entrada mono.

◦ Delay – Regula o comprimento do atraso em milésimos de segundo, o que muda al altura da ressonância resultante. Ajustes mais altos criam ressonância de alturas baixas e os mais baixos criam ressonâncias de alturas mais altas.

◦ Speed – Ajuste da velocidade das linhas de atraso. Quanto mais baixos, efeitos mais lentos, e quanto mais altos efeitos mais rápidos e agressivos.

◦ Width – Graduação das linhas de modulação do atraso. Configurações baixas produzem efeitos de Flanger mais sutis, enquanto configurações mais altas produzem mudanças mais pronunciadas no timbre ao longo do tempo.

◦ Feedback (FB) – Este controle permite que você defina a quantidade de sinal de saída para retornar ao Flanger. Quantidades mais elevadas de realimentação aumentam a ressonância do efeito de varredura.

◦ Sync – Ative esta opção para habilitar a configuração da velocidade de modificação do Flanger para um valor de tempo (como notas de 1/2 ou 1 tempo)) em relação ao tempo da música. Desative para definir a velocidade em uma escala contínua.

◦ Depth – Controla a mistura entre o sinal sem efeito (todo para a esquerda) e com efeito (todo para a direita).

• Phaser – Este processador cria efeitos de varredura sonhadores, de ficção científica. O sinal de sintetizador é alimentado através de uma série de filtros de passa-bandas que alteram sua fase. Quando misturado com o sinal de entrada, surge uma série de altos e baixos na resposta de freqüência que muda dependendo do grau de mudança de fase aplicado. Oferece os seguintes controles:

◦ Mono – Ative para misturar o sinal de entrada mono com o de saída com efeito.

◦ Shift – Esse controle permite especificar a quantidade de mudança de fase a ser aplicada. As configurações mais baixas enfocam o efeito de fase nas freqüências mais baixas, enquanto as configurações mais altas focalizam o efeito em freqüências mais altas.

◦ Speed – Este controle permite que você defina a velocidade de modulação aplicada ao valor da mudança de fase. As configurações mais baixas criam efeitos lentos e de varredura, enquanto as configurações mais altas criam uma modulação mais rápida e agressiva.

◦ Width – Este controle permite que você defina o grau em que a quantidade de deslocamento de fase é modulada. As configurações mais baixas produzem efeitos mais sutis, enquanto configurações mais altas produzem mudanças mais pronunciadas no timbre ao longo do tempo.

◦ Feedback (FB) – Este controle permite que você defina a quantidade de sinal de saída para retornar ao Phaser. Quantidades mais elevadas de realimentação aumentam a ressonância do efeito de varredura.

◦ Sync – Ative esta opção para habilitar a configuração da velocidade de modulação para um valor de tempo (como notas de 1/2 ou de 1 tempo)) em relação ao tempo da música. Desative para definir a taxa em uma escala contínua.

◦ Depth – Este controle permite misturar entre o sinal sem efeito (todo à esquerda) e o sinal de mudança de fase (todo à direita).

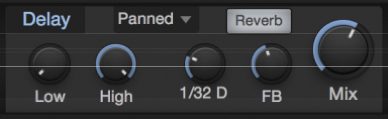

Delay

Delay

Este processador cria um efeito de eco, como uma única repetição atrasada do sinal de entrada ou uma série de ecos que se seguem. O efeito Delay oferece os seguintes controles:

• Low and High – Esses controles permitem que você defina as freqüências de corte dos filtros de passa-altas e baixas fornecidos, que apenas produzem sinais atrasados.

• Delay Time – Este controle permite que você especifique o comprimento do atraso, em valores de tempo (como quartos de tempo ou meios-tempos) em relação ao tempo da música.

• Feedback (FB) – Este controle permite que você defina a quantidade de sinal afetado que é alimentado de volta ao efeito. Em zero, há apenas uma repetição. À medida que você aumenta o valor, as repetições crescem.

• Mix – Mistura o sinal de entrada sem efeito (todo à esquerda) e com efeito (todo à direita).

◦ Ping-Pong Mode – Este menu permite ativar e configurar o modo de atraso de Ping-Pong estéreo. Você pode escolher entre os seguintes modos:

◦ Off – Funciona sem o modo Ping-Pong.

◦ Panned – Usando uma estrutura de atraso múltipla, esse modo exibe cada repetição de atraso para a direita ou a esquerda, em sequência.

◦ Dotted and Double – Estes modos funcionam de forma semelhante ao modo Panned, mas empregam espaçamento escalonado nos atrasos para produzir uma nota pontuada (com seu tempo aumentado em mais a metade do seu valor) ou um ritmo alterado da mesma forma nas repetições de atraso.

• Reverb – Habilite esta opção para encaminhar a saída do efeito Delay para o efeito Reverb, permitindo uma maior difusão do sinal de atraso.

Reverb

Reverb

Este efeito coloca o sinal de sintetizador dentro de um espaço físico reverberante virtual, variando de reverberações curtas que imitam salas menores, a longos reverbs que imitam sons de grandes espaços, como teatros e catedrais. O Reverb oferece os seguintes controles:

• Pre-Delay (Pre) – Este parâmetro permite especificar uma quantidade de atraso aplicada ao sinal processado por reverb, num intervalo entre zero e 500 ms. Isso imita o atraso existente nos grandes espaços, entre o impacto de um som e seus reflexos percebidos pelo ouvido. As configurações mais baixas são mais adequadas para tempos de reverberação mais curtos e configurações mais longas com tempos de reverberação mais longos, mas deixe seu próprio gosto ser o juiz.

• Damping – Este controle permite que você defina uma quantidade de atenuação de alta freqüência para se aplicar ao sinal de reverberação. Espaços com superfícies macias tendem a perder agudos rapidamente à medida que o som reverbera, resultando em uma reverberação brilhante curta seguido de um “rabo” progressivamente mais escuro. Espaços com superfícies mais duras mantêm o high-end de forma mais eficiente ao longo do tempo. Ajuste o amortecimento a valores inferiores para emular superfícies duras, e para valores mais altos para permitir um amortecimento adicional, simulando superfícies mais suaves.

• Size – Este controle permite que você defina o comprimento da reverberação a partir do momento em que um som é iniciado, em um intervalo entre 100 ms e 10 segundos. Quanto maior o tamanho, maior o rabo do reverb e maior vai soar o espaço emulado.

• Low and High – Esses controles permitem que você defina as freqüências de corte dos filtros de passa-altas e baixas fornecidos, que apenas produzem o sinal de reverberação.

• Mix – Este controle permite que você misture entre o sinal sem efeito (todo à esquerda) e o sinal de reverb (todo à direita).

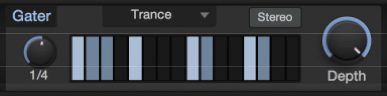

Gater

Gater

Este é um efeito rítmico, capaz de criar uma série de quebras swingadas no sintetizador. Uma variedade de presets são fornecidos, cada um com um padrão de “portas” rítmicas diferente. No entanto, o bicho é você criar a sua própria porta. Oferece os seguintes controles:

• Beats – Este controle permite que você defina o comprimento do ciclo de gating, em valores rítmicos (como 1 compasso de 4 tempos ou uma nota de 2 tempos) em relação ao tempo da música. Por exemplo, em uma configuração de 1 compasso, as 16 etapas do ciclo repetem cada compasso, representando as 16 notas de 1/4 de tempo. Em uma configuração de nota de 2 tempos, os 16 passos repetem cada meio compasso (de 4 tempos), representando valores de notas de 1/8 de tempo.

• Beat Steps – Esta grade permite que você especifique quais as etapas no ciclo em que o sinal passa, e quais bloqueiam o sinal. Clique em uma etapa para ativar ou desativar o gating para essa etapa.

• Stereo – Ative esta opção para criar uma grade de batidas separada para cada lado do campo estéreo. Quando ativada, você verá duas etapas de batida, a linha superior especificando as etapas do canal esquerdo e a linha inferior para o canal direito.

• Depth – Este controle permite misturar entre os sinais fechados e secos, permitindo efeitos de bloqueio rítmico, mantendo a continuidade do som do sintetizador.

Distortion

Distortion

Este é um efeito de distorção variável, que adiciona características “sujas” aos seus sons. Escolha entre uma variedade de tipos de distorção, de ligeiras saturações até distorções “gordas” de amplificadores valvulados. Defina a quantidade de distorção com o botão Drive.

Pan

Este é um efeito de auto-panorâmica, que exibe o sinal de sintetizador dos canais esquerdo e direito ao longo do tempo. O Pan oferece os seguintes controles:

• Speed – Este controle permite que você defina a velocidade na qual o sinal é dividido para a esquerda e para a direita.

◦ Sync – Ative esta opção para definir a velocidade do estéreo em um valor de tempo (como notas de 1/4 ou 1/8 de tempo) em relação ao tempo da música. Desative esta opção para configurar a velocidade do estéreo de forma contínua.

◦ Depth – Este controle permite que você defina o grau em que o sinal é cortado. As configurações mais baixas dão um efeito mais leve, enquanto as configurações mais elevadas dividem o sinal de forma mais radical, completamente para a esquerda ou para a direita em cada ciclo.

Modulation Matrix

Modulation Matrix

O Mai Tai fornece 16 roteiros de modulação configuráveis, em dois bancos de oito (Mod A e Mod B). Os sinais de modulação podem ser encaminhados a partir de uma seleção de sinais de controle MIDI de entrada (como Pitch Bend, Mod Wheel e Aftertouch), geradores de modulação (como LFOs e envelopes), ou altura ou a intensidade das notas tocadas.

Esses sinais de modulação podem ser usados para variar a maioria dos parâmetros do Mai Tai, incluindo as próprias fontes de modulação (como LFO 2 modulando a taxa de LFO 1 ou Decay of Env 2)

Cada slot de modulação possui um botão de liga/desliga na parte superior, que permite ativar ou desativar o fluxo do sinal de modulação. Abaixo estão os seletores de entrada e seletor de modificador. Se você atribuir apenas uma fonte de modulação ao seletor de entrada, esse sinal é encaminhado diretamente para o destino escolhido. Em alguns casos, você controla o fluxo de uma fonte de mod antes dela chegar ao seu destino, usando o sinal de outra fonte de modificação. Por exemplo, você pode querer controlar o nível de saída do LFO 1 (roteado para um parâmetro, como o passo do oscilador) com a “rodinha” Mod. Nesse caso, você escolheria Mod Wheel como o seletor de entrada e LFO 1 como o seletor de modificador abaixo.

Abaixo está um controle deslizante que controla a amplitude e a polaridade do sinal de modulação. Em seu centro, nenhuma modulação ocorre. Mova a alça direita do centro para enviar uma quantidade crescente do sinal de modulação, na sua polaridade normal (positiva), para o destino escolhido. Mova-o para a esquerda do centro para enviar o sinal para o seu destino com um valor negativo.

Se o parâmetro que você deseja modular é configurado para um valor alto, você pode enviar um sinal de modulação negativa, dirigindo a configuração para baixo e causando efeitos mais audíveis. Os sinais de modulação positivos são mais eficientes quando a modulação de parâmetros é ajustada para valores baixos.

Um seletor na parte inferior de cada slot de modulação permite que você escolha o destino dos sinais de modulação escolhidos.

Virtual Keyboard

Observe que, para uma experiência de teclado mais fácil, quando estiver longe do seu controlador MIDI, você também pode usar o Dispositivo de teclado QWERTY do Studio One para reproduzir notas usando o teclado do seu computador.

Ao lado do teclado virtual está o parâmetro Bend, que permite definir o intervalo de pitch pitch da roda Pitch, em semitons. O valor superior configura o intervalo de curvatura e o valor inferior define o intervalo de curvatura.

Audio Profissional

Inteligência artificial na música: recortes, fatos e análises

Nesse artigo consideramos o impacto da IA (Inteligência artificial) no processo criativo e técnico da produção musical.

Um setor em particular, a pós-produção de áudio, está passando por mudanças mais rápidas devido a AI. Isso significa grandes mudanças, agora e no futuro, para habilidades, emprego e trabalho. Muitos relatos sobre o papel da automação de máquinas na instabilidade ocupacional – especificamente, reduções no emprego humano. Essa artigo mostra em tópicos como esse processo está começando a alterar a cadeia de produção musical e também as novas tecnologias que podem substituir ou aumentar o potencial humano nessa área.

1 – O que é inteligência artificial?

A inteligência artificial (IA) é um ramo abrangente da ciência da computação preocupado com a construção de máquinas e algoritmos inteligentes capazes de realizar tarefas que normalmente requerem inteligência humana. Embora a IA seja uma ciência interdisciplinar com várias abordagens, os avanços no aprendizado de máquina e no aprendizado profundo , em particular, estão criando uma mudança de paradigma em praticamente todos os setores da indústria de tecnologia.

A inteligência artificial permite que as máquinas modelem, ou até melhorem, as capacidades da mente humana. E desde o desenvolvimento de carros autônomos até a proliferação de ferramentas generativas de IA como ChatGPT e Googles Bard, a IA está se tornando cada vez mais parte da vida cotidiana das pessoas comuns e dos profissionais.

2 – As primeiras aplicações da IA no áudio

As primeiras tentativas de música gerada por computador apareceram na década de 1950 com foco na criação de música algorítmica. O advento da música gerada por computador por pioneiros como Alan Turing com o computador Manchester Mark II abriu múltiplas possibilidades de pesquisa em inteligência musical onde sistemas computacionais poderiam reconhecer, criar e analisar música.

Turing ajudou a criar uma das primeiras gravações de música de computador, reaproveitando sons de sinal em um dos primeiros computadores de Manchester. Foto da Biblioteca de imagens da Science & Society.

Especificamente, os primeiros experimentos se concentraram na composição algorítmica (um computador que usa conjuntos formais de regras para criar música). Em 1957, vimos a primeira obra composta exclusivamente por inteligência artificial — Illiac Suite for String Quartet.

Lejaren Hiller e Leonard Isaacson. Foto do Illinois Distributed Museum

Através do uso de modelos matemáticos e algoritmos, Lejaren Hiller (um compositor americano) e Leonard Isaacson (um compositor e matemático americano) criaram Illiac Suite, a primeira peça original composta por um computador. Para conseguir essa façanha, eles usaram um algoritmo de Monte Carlo que gerava números aleatórios que correspondiam a certas características musicais como tom ou ritmo. Usando um conjunto de restrições, essas características aleatórias foram limitadas a elementos que seriam musicalmente ‘legais’ conforme definido pelas regras da teoria musical tradicional, probabilidades estatísticas (como cadeias de Markov) e a imaginação dos dois compositores.

Outro inovador neste campo foi Iannis Xenakis, um compositor e engenheiro, que usou probabilidades estocásticas para auxiliar na criação de sua música. Um processo estocástico é um mecanismo com distribuições de probabilidade aleatórias que não podem ser previstas, mas podem ser analisadas estatisticamente. No início dos anos 60, ele utilizou computadores e a linguagem FORTRAN para entrelaçar múltiplas funções de probabilidade para determinar a estrutura geral e outros parâmetros (como tom e dinâmica) de uma composição.

Xenakis modelou sua música como se estivesse modelando um experimento científico. Cada instrumento era como uma molécula e passaria por seu próprio processo estocástico e aleatório para determinar seu comportamento (a frequência do tom e a velocidade de certas notas). Seu trabalho introduziu novos métodos para a criação de som, mas também serviu como um dos primeiros exemplos de IA funcionando como uma ferramenta de análise complementar, em vez de apenas uma ferramenta de composição. A forma como Xenakis criava suas melodias e orquestrações para diferentes instrumentos se inspirava nos espaços sonoros modelados pelo processo estocástico.

Em 1965, o inventor Ray Kurzweil estreou uma peça para piano criada por um computador capaz de reconhecer padrões em várias composições. O computador foi então capaz de analisar e usar esses padrões para criar novas melodias. O computador estreou no programa de perguntas e respostas I’ve Got a Secret e deixou os apresentadores perplexos até que o astro de cinema Henry Morgan adivinhou o segredo de Ray.

Em 1997, um programa de inteligência artificial chamado Experiments in Musical Intelligence (EMI) parecia superar um compositor humano na tarefa de compor uma peça musical para imitar o estilo de Bach . (Fonte: Wikipedia )

3 – Período de transição – Modelagem generativa (1980 – 1990)

Nas décadas que antecederam a era moderna da música, o foco mudou da geração algorítmica mais simples para a modelagem generativa. Otto Laske, proeminente pesquisador no campo da áudio, descreve essa mudança como a diferença entre um robô musical e uma inteligência musical.

Um robô musical é mais parecido com os primeiros experimentos dos anos 50 e 60 – ele pode reconhecer padrões, tem uma gramática para música e tem um senso geral de resolução de problemas, mas atinge seus objetivos com métodos bastante diretos e contundentes. Por outro lado, a inteligência musical substitui a abordagem de busca de força bruta do robô por um sistema de compreensão baseado em conhecimento com sua própria consciência de como os elementos musicais podem funcionar. Essa tendência de sistemas de IA construírem sua própria compreensão autossuficiente de elementos musicais foi a base para a inteligência musical mais sofisticados que vemos hoje. Outros desenvolvimentos neste período continuaram a explorar os limites da criatividade computacional. Por exemplo, Robert Rowe criou um sistema em que uma máquina pode inferir a métrica, o andamento e as durações das notas enquanto alguém toca livremente em um teclado. Também em 1995, a Imagination Engines treinou uma rede neural com melodias populares, ativando o aprendizado por reforço, levando à geração de mais de 10.000 novos refrões musicais. O aprendizado por reforço envolve o treinamento de uma rede neural para atingir um objetivo, recompensando/punindo o modelo com base nas decisões que ele toma para atingir um objetivo especificado.

4 – Período atual (anos 2000 – presente)

Durante a década de 2010, testemunhamos o surgimento de algoritmos de aprendizado de máquina inteligentes e rápidos e sua integração gradual em software de produção musical. Agora, os cérebros artificiais de incontáveis plug-ins, plataformas, suítes de masterização virtual (https://www.landr.com) e até mesmo compositores estão prontamente ao volante como motoristas conscientes das ferramentas criativas de hoje.

Vejamos abaixo alguns desses aplicativos inteligentes:

Síntese Vocal Avançada: Os clones vocais deepfake de artistas famosos provocaram sentimentos contraditórios na indústria da música. No entanto, no fundo, os mesmos avanços estão ajudando a empurrar a síntese vocal para um novo território.

Tentar construir uma voz humana com um computador não é nada novo. Um sintetizador de canto como o VOCALOID6 tem uma história que remonta aos anos 2000 e, em sua iteração mais recente, começou a usar IA para melhorar o instrumento de voz sintetizada. Você pode digitar as letras, selecionar o tom e ajustar o sotaque. Pode cantar em japonês e inglês e, a partir de 2023, chinês também.

Assim como qualquer instrumento de software, como um piano virtual, ele tenta recriar a coisa real. Mas ao contrário de como a música deepfake é criada , a empresa trabalhou com cantores reais para desenvolver vários perfis vocais.

Se você está procurando uma alternativa mais jovem, experimente o Synthesizer V da Dreamtonics . A empresa foi fundada em 2019 no momento em que a tecnologia de IA começou a acelerar e atingir o status de mainstream, e os resultados são impressionantes

Concebido pela primeira vez em 2001, o Continuator era um software de aprendizado de máquina. Ele reuniu dados sobre como os músicos tocavam e aprendeu a complementá-los de maneira inteligente, improvisando em tempo real usando os dados coletados sobre como eles tocavam como modelo. Seu inventor, François Patchet, viria a ser um grande jogador no desenvolvimento do Spotify.

Entre as primeiras grandes aplicações de IA em plug-ins de mixagem de música, o Adaptiverb da Zynaptiq inspeciona o áudio de origem e, usando o ressintetizador Bionic Sustain, cria a cauda de reverberação perfeita e sob medida, por meio de centenas de osciladores em rede. Ele estabeleceu um novo precedente para destacar os benefícios práticos do aprendizado de máquina em toda a produção.

Tecnologia Assistiva de Áudio da iZotope (2016)

Izotope; uma empresa que abraçou o potencial de economia de tempo da IA como poucas outras, a útil tecnologia de áudio assistido da iZotope é o molho secreto por trás de produtos emblemáticos como RX de aprimoramento de áudio e Ozone de aperfeiçoamento de som. Ao analisar o áudio de forma inteligente e aplicar correções rápidas, o iZotope provavelmente economizou coletivamente anos preciosos dos profissionais no estúdio.

5 – Como a IA está mudando a tecnologia de áudio

“Uma vez que o método de pensamento da máquina tivesse começado, não demoraria muito para superar nossos fracos poderes. Eles seriam capazes de conversar uns com os outros para aguçar sua inteligência. Em algum momento, portanto, devemos esperar que as máquinas assumam o controle”. Assim como a previsão sombria que o pai da inteligência artificial, o gênio da computação Alan Turing previu. Embora, felizmente, ainda não estejamos enfrentando um ponto final tão assustador, a noção de Turing de um cibercérebro controlado por uma máquina, continuamente aguçando seus sentidos por meio de diálogo e refinamento constantes, é um conceito que está no cerne da aplicação comercial de inteligência artificial

Em nossa indústria, podemos ver isso talvez mais claramente do que qualquer outro. Multidões de ferramentas de software baseadas em IA agora disponíveis, que se destacam em tarefas (como edição de frequência, separação de mixagem, restauração de áudio e masterização) que levariam muito, muito mais tempo para serem executadas por operadores humanos altamente qualificados. O refinamento constante e as rotinas de aprendizado adaptativo permitem que os caminhos de software baseados em IA sejam aprimorados. Embora o termo ‘inteligência artificial’ seja normalmente atribuído a qualquer software que dependa de algoritmos para cumprir seus critérios, na verdade existe um amplo espectro de definições. Existem aqueles que simplesmente desencadeiam uma série de ações pré-determinadas que seus criadores criaram cuidadosamente e existem aqueles gênios virtuais semelhantes a HAL (iZotope RX 9 , Zynaptiq Adaptiverbpor exemplo) que pode inspecionar uma forma de onda, diagnosticar com precisão o que precisa ser feito para trazer mais clareza a ela.

Melissa Misicka, Diretora de Brand Marketing da iZotope, nos explica que usar a inteligência artificial para esse fim sempre foi uma ambição da empresa; “Um de nossos objetivos como empresa é encontrar maneiras de eliminar tarefas de produção de áudio mais demoradas para nossos usuários, para que eles possam se concentrar em sua visão criativa. Apresentar a tecnologia assistiva – que pode analisar seu áudio de forma inteligente e fornecer pontos de partida recomendados – pareceu uma maneira perfeita de fazer isso.”

Não se trata apenas de tornar os processos demorados mais rápidos. Muitos veem a IA como um método para realizar as tarefas que os humanos são incapazes de realizar. A iZotope explica como essa ideia foi colocada em prática. “Um exemplo é a separação de fontes para limpeza de fala.” Misicka nos diz: “Nossos módulos como Dialogue Isolate ou De-rustle dependem dele para atenuar sons indesejados como passos, chilrear de pássaros ou farfalhar de um microfone escondido nas roupas. O reparo manual desses ruídos seria muito trabalhoso, pois os ruídos mudam no tempo e se sobrepõem à fala”

“Outro exemplo é a síntese inteligente de sons de substituição.” Melissa continua: “Quando a fala vem de uma chamada telefônica, seu espectro de frequência fica limitado a 4 kHz, o que resulta em um som abafado característico. O módulo Spectral Recovery do RX usa aprendizado de máquina para recriar a banda de frequência superior ausente com conteúdo sintetizado realista para melhorar a qualidade da fala. As formas manuais de síntese de alta frequência incluiriam ferramentas como um excitador, mas a qualidade e a plausibilidade do conteúdo sintetizado não chegariam nem perto dos resultados do aprendizado da AI.

Sonible

A gama de plug-ins Sonible apresenta “ pure:comp ”, “ pure:verb ” e “ pure:limit ”, entre muitos outros. Projetados pensando nos criadores, esses plug-ins oferecem aprimoramento de som de nível profissional usando tecnologias de ponta. O conjunto de controle simplificado permite modelagem de som sem esforço, com opções poderosas para ajustar sua mixagem.

“ Pure:limit ” equilibra a dinâmica e encontra o nível perfeito para sua mixagem com apenas um toque de um botão. Enquanto isso, “ pure:comp ” e “ pure:verb ” oferecem processamento alimentado por IA e perfis característicos, parametrizando automaticamente para resultados de alta qualidade.

RoEx é uma plataforma da web onde produtores, músicos e podcasters podem enviar seu áudio, fornecer algumas configurações simples e obter um produto final polido e com som profissional em poucos minutos. A tecnologia inovadora cuida de todo o trabalho mundano, permitindo que você se concentre em ser criativo. Depois que a IA terminar de mixar, sua faixa estará pronta para distribuição imediatamente. Nenhum trabalho tedioso de pós-produção ou revisões intermináveis. Os serviços de mixagem AI também são fornecidos como uma API escalável e rápida. Isso significa que você pode integrar facilmente a tecnologia RoEx em seu fluxo de trabalho existente, permitindo otimizar ainda mais seu processo de produção.

Uma das aplicações mais benéficas da IA para músicos domésticos tem sido a rápida disponibilidade de serviços de masterização orientados por algoritmos. Tome LANDR por exemplo, o software perspicaz deste serviço de assinatura se apoia em uma mina de inteligência extraída de 20 milhões de faixas masterizadas. Ele usa essas informações para calcular como aplica o aumento de frequência personalizado e o brilho auditivo à sua música. “Quando o LANDR foi lançado pela primeira vez em 2014, era a primeira solução desse tipo para masterização de IA baseada em nuvem”. Patrick Bourget, Diretor de Produto da LANDR, nos conta. “Em 2016, o cenário começou a ver alternativas semelhantes, mas muito menos refinadas, surgindo no mercado.”

6 – Inteligência artificial vs Humanidade

Com a prevalência cotidiana de plataformas como LANDR, Patrick Bourget parece uma boa pessoa para perguntar sobre como ele vê essa dinâmica humano/máquina evoluindo no futuro, especificamente no domínio de masterização; “Dado o ritmo acelerado de criação e os orçamentos muitas vezes apertados dos produtores musicais em todo o mundo, sentimos que sempre haverá espaço para os engenheiros de masterização e masterização de IA “. Mas fora da masterização a sensação geral é que a IA veio para somar e não para substituir o processo humano na música e no áudio.

A iZotope ecoa este ponto fundamental, de que as aplicações de inteligência artificial mais bem-sucedidas até hoje são aquelas que ajudam criativos e profissionais a atingir seus objetivos, e não aquelas que buscam suplantá-los. “Muitas vezes imaginamos nossa tecnologia assistiva como, literalmente, um assistente de estúdio que pode dar o primeiro passo nos reparos ou fazer uma mixagem para você enquanto você toma um café.” Melissa explica: “Reforçamos que a missão das ferramentas de assistência da iZotope não é substituir a experiência profissional, mas treinar aqueles que ainda estão aprendendo, sugerindo os próximos passos, e ajudar aqueles que são mais experientes, levando-os a um ponto de partida. mais rapidamente.”

Embora seja indiscutível que a inteligência artificial continuará a penetrar em nossas vidas diárias em muitos níveis, é claramente aparente que, em vez de encolher diante de seu potencial insondável, músicos e produtores têm mais a ganhar do que perder com suas habilidades em constante desenvolvimento.

7 – As vantagens da mixagem e masterização com a IA

•Consistência: A mixagem e masterização AI podem ajudá-lo a garantir a consistência em várias faixas, fazendo com que soem como se estivessem juntas e também uma mix com mais transparência e definição.

•Economia de tempo: A mixagem e masterização AI podem economizar tempo automatizando todo o processo de masterização. Em vez de dominar manualmente cada faixa, as ferramentas de IA podem analisar e aprimorar várias faixas em questão de minutos.

•Custo-benefício: As ferramentas de mixagem e masterização de IA são muito mais baratas do que contratar um profissional. Elimina a necessidade de pagar pelo tempo de estúdio e pelos serviços de um engenheiro de mixagem/masterização.

•Acessibilidade: O software AI é acessível a todos, independentemente do nível de experiência em produção musical. O processo é simplificado e fácil de usar, permitindo que você se concentre nos aspectos criativos de sua música sem se prender aos detalhes técnicos.

8 – As desvantagens da mixagem e masterização com IA

•Masterização online instantânea: Landr, eMastered e AI Mastering:

Landr , eMastered e AI Mastering são serviços que dominam as faixas instantaneamente, e tudo o que você precisa fazer é carregar a faixa. É bastante barato, variando de $ 5 a $ 39 por mês, e é rápido. (Junte isso com sites lindamente projetados e você terá toda a atenção da geração do milênio). Existem alguns problemas com esses serviços: eles oferecem opções mínimas de edição e, simplesmente não soam tão bem quanto a masterização humana. Você está preso com a masterização que eles lhe dão, não há opções de ajuste fino disponíveis. Quando se trata de comparações lado a lado com o domínio humano, Landr e seus contemporâneos simplesmente não fazem o corte.

Resumindo: Landr, eMastered e AI Mastering são ótimos se você estiver com um orçamento apertado ou com pouco tempo, mas definitivamente não são suas melhores opções. Definitivamente sugeriria aprender a dominar suas próprias faixas ou enviar suas faixas para um profissional.

•Plug-ins híbridos AI/Manual: iZotope’s Neutron 3 Mixing Assistant e Ozone 9 Mastering Assistant:

As versões mais recentes do IZotope de seus aclamados plug-ins Neutron e Ozone agora incluem alguns elementos de IA. O Neutron 3 apresenta Mixing and Balance Assistant e o Ozone 9 agora possui um Mastering Assistant. Cada uma dessas ferramentas do Assistente ouve sua música em tempo real (ainda sem carregamento off-line) e equilibra, mixa ou masteriza sua música automaticamente. Cada um deles tem predefinições que você pode escolher e algumas maneiras de personalizar o resultado. Essas ferramentas são bastante úteis, mas não devem ser o fim de tudo.

Esses assistentes de mixagem e masterização funcionam bem como ponto de partida ou se você quiser apenas experimentar algo diferente. Os assistentes eliminam muito do trabalho pesado, mas ainda precisam de um ouvido treinado para obter o som certo. Além disso, posso definitivamente prever alguns casos em que tentar fazer com que o assistente de IA identifique os instrumentos corretamente pode dar mais trabalho do que vale a pena. No entanto, se você for seguir o caminho da IA, essas ferramentas são definitivamente o melhor caminho a percorrer.

Em resumo, o software de mixagem e masterização AI pode economizar tempo e dinheiro e isso é especialmente importante para produtores que estão apenas começando e têm recursos limitados. No entanto, existem algumas desvantagens reais na masterização que devem ser consideradas antes de entrar na onda da IA.

Aqui estão algumas vantagens da masterização manual analógica:

1 – Na masterização analógica: equipamentos de alta qualidade que irá incorporar sua assinatura sônica no seu áudio (mesmo sendo somente um summing).

2 – A experiência dedicada do profissional de anos de serviços técnico nessa área.

3 – Possível revisão com sugestões para a sua mix.

4 – Aquele toque humano final que dará mais vida e calor à sua música.

9 – IA e direitos autorais

Quem é o dono da música gerada por inteligência artificial? E se o software de IA pode ser inspirado por músicas existentes e gerar novas músicas de estilo semelhante, os direitos autorais se tornam uma área cinzenta?

Como toda nova área da tecnologia, a IA promete gerar muito trabalho para os advogados. Cliff Fluet, da empresa de consultoria de mídia Eleven, insiste: “Não é nada cinza. É que as pessoas não gostam de ouvir a resposta, dependendo do que estão fazendo. Mas você fez a pergunta-chave e há um monte de advogados especulando sobre isso! “Essa é uma pergunta tão boa ou tão ruim quanto perguntar quem é o dono de um filme. A verdadeira resposta é que depende de como você o fez, quanto é seu e quanto pertence a outra pessoa. Até que ponto você está recebendo informações de atores, cenógrafos, terceiros e assim por diante? Até que ponto você criou algo totalmente original? A resposta é tão simples e sofisticada quanto isso. Cada um depende de como seus processos, como seus algoritmos, como suas escolhas são feitas. Se você for um advogado realmente bom, a resposta é muito, muito simples, desde que você realmente entenda a profundidade dos processos. Dado que a IA para produção musical é uma tecnologia emergente, essa é uma área legalmente testada?

Cliff Fluet: “Eu diria que é e não é. A lei sobre direitos autorais de música foi construída sobre uma tecnologia altamente não confiável chamada músicos e o cérebro humano. Você tem pessoas perguntando ‘E se uma máquina replicar outra coisa?’ – e é como ‘Bem, e se um artista replicar outra coisa?’, que é o que acontece todos os dias na indústria da música. Há perguntas reais sobre alguém realmente ouviu algo ou não? Alguém realmente adaptou algo? A lei não é diferente quando se trata de uma máquina ou de um ser humano. A diferença entre um ser humano e uma máquina é que com uma máquina você tem provas absolutas.”

Cliff aponta para casos legais anteriores em que “o júri tem que sentar e tentar descobrir se alguém ouviu algo, adaptou algo ou fez. Com uma máquina, você não precisa confiar em sua memória, você literalmente pode ver todas as notas lá, então, na verdade, acho que é mais fácil do que mais difícil. Descobrir se um humano roubou ou não uma composição ou se é dono ou não, ou se a compartilhou ou não, é muito, muito mais complexo do que uma máquina. No mínimo, os avanços na tecnologia podem ajudar.”

10 – O futuro da música com a IA

É provável que o futuro veja uma explosão de novas músicas criadas por pessoas que antes não tinham meios para fazê-lo, habilitadas por ferramentas baseadas em IA. Da mesma forma, músicos e produtores provavelmente encontrarão mais tempo para serem criativos e criar músicas de novas maneiras, deixando a IA para gerenciar tarefas funcionais repetitivas. É provável que a criação de música se torne parte das interações online das pessoas, com os consumidores criando e compartilhando novas músicas por meio de plataformas de mídia social.

A IA para produção e consumo de música é uma área enorme, e este artigo só pode oferecer uma amostra da pesquisa e desenvolvimento contínuos para serviços de música de IA. Como diz Cliff Fluet, “IA vai se tornar um termo tão útil quanto falar sobre ‘a Internet’. Vinte anos atrás, se eu tentasse descrever a Internet, você pensaria que era apenas uma plataforma – e na verdade foi o primeiro passo para algo enorme.”

As ricas oportunidades em torno da IA levantam muitas questões e, até o momento, temos apenas algumas respostas. Muitos desenvolvimentos estão em sua infância e alguns timings permanecem incertos. O que é certo é que a IA estar recebendo muita atenção de grandes gravadoras, artistas número um, incubadoras de negócios e desenvolvedores de software de ponta, então as mudanças estão a caminho. Muitos colaboradores estimam que veremos uma mudança na produção e consumo de música nos próximos cinco a sete anos. A adoção generalizada se reduzirá à facilidade com que podemos interagir com nossas ferramentas de IA e à qualidade dos resultados finais, que estão avançando constantemente. Como acontece com qualquer tecnologia emergente, temos claramente a opção de usá-la e como queremos usá-la, e pode ser o mercado que molda a direção do software de IA. Todos os nossos colaboradores fizeram questão de enfatizar que a IA não substituirá artistas ou produtores. Paradoxalmente, quanto mais usamos IA na música, mais podemos aproximar as pessoas.

Pascal Pilon, da LANDR

Aponta que “a indústria da música é retardatária em muitos aspectos. Veja o mercado financeiro e como start-ups em todo o mundo estão buscando financiamento para desenvolver e comercializar produtos com a ajuda de parceiros de capital de risco. Na indústria da música, esse papel tem sido historicamente desempenhado pela gravadora, mas fechar um acordo com as gravadoras ainda é muito rudimentar. Acho que o modelo de financiamento da indústria da música se tornará cada vez mais baseado em dados, mais competitivo. Isso atrairá mais capital de um conjunto mais amplo de investidores, ainda envolvendo gravadoras, mas também um conjunto maior de pequenos a grandes investidores anjos”.

Pascal prevê que as gravadoras ainda precisarão investir pesadamente em talentos para promover a música. “Mesmo que haja IA, você ainda precisará de pessoas para trazer visibilidade aos artistas. Pense em marketing: a coisa mais rara que você consegue são ouvintes no espaço musical que gastam. Sua capacidade de levar as pessoas a ouvi-lo ainda exigirá um elenco de colaboradores do ponto de vista do marketing. Novamente, é muito semelhante à indústria cinematográfica. Veja como o orçamento de produção é importante – sim, eles são enormes, mas pense no orçamento comercial, que é ainda maior. Para chamar a atenção das pessoas, você precisará gastar em canais para entregar isso – pense no Facebook. Se você puder trazer viralidade para empresas como o Google e o YouTube, poderá ser independente, mas isso exigirá muita sofisticação do ponto de vista da promoção.”

11 – Considerações finais

A inevitável integração cada vez mais ampla da Inteligência Artificial no campo da produção musical aponta para uma era de transformações iminentes, estamos diante da necessidade de nos prepararmos para esta revolução por meio de estudos, pesquisas e capacitação, a fim de otimizar sua aplicação. É crucial enfatizar que esse processo está intrinsecamente ligado a elementos como plugins, aplicativos e DAWs, os quais imprimem sua qualidade sônica ao resultado final, e principalmente no contexto da masterização assistida por IA, a excelência do desfecho dependerá diretamente da qualidade do software empregado e do seu uso da forma correta.

Do meu ponto de vista (Marlon Porto) é inegável que, até o momento, a qualidade sonora proporcionada por compressores, equalizadores, processadores e conversores especializados em masterização predominantemente analógicos, permanecem insuperáveis com resultados diferenciados, seguindo assim o padrão da indústria fonográfica.

Já na restauração; os softwares dedicados são insuperáveis com suas IAs. Na esfera da mixagem, embora o impacto seja menor até agora, é imperativo que as startups também reconheçam essa preocupação, pois a qualidade e autenticidade sônica desempenham um papel importante, além disso, o algoritmo subjacente ao modelo de IA deve desempenhar um papel crucial na otimização do processo, porém sem comprometer outros elementos da mixagem, é crucial adotar uma abordagem consciente no uso destas tecnologias em evolução, pois enfrentamos um horizonte promissor, porém desafiador e uma mistura dos dois mundos é o recomendado até o momento.

*Autor: Marlon Porto é técnico de áudio da Promaster studio

Fontes de pesquisas e recortes:

- https://watt-ai.github.io/blog/music_ai_evolution

- https://en.wikipedia.org/wiki/Music_and_artificial_intelligence

- https://www.musicradar.com/news/the-history-of-ai-in-music-production

- https://audiomediainternational.com/artificial-intelligence-in-music/

- https://www.soundelicit.com/disadvantages-of-ai-mixing-and-mastering/

- https://www.lalal.ai/blog/best-ai-mixing-mastering-tools/

- https://www.soundonsound.com/music-business/ai-music

Tutorial áudio

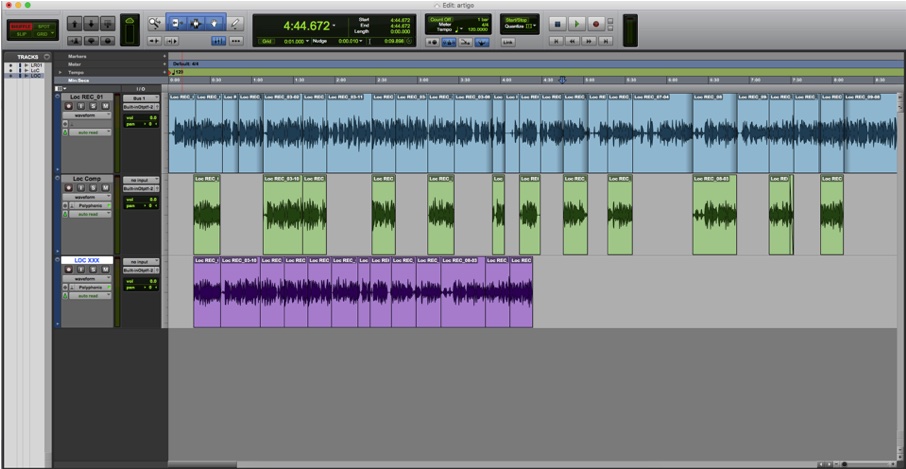

Tutorial – Uma nova maneira de gravar locução

Uma das partes fundamentais da pós – produção de áudio é a produção das locuções. Elas estão presentes em filmes, vídeos institucionais para publicidade, dublagens e audiolivros.

Basicamente o processo de produção de locuções é o mesmo para qualquer instrumento, onde primeiramente ocorre a gravação dos áudios, edição e mixagem. A gravação normalmente requer bastante atenção e expertise do engenheiro, pois é nessa etapa que se garante a qualidade sonora. Engenheiros com mais experiência conseguem fazer o processo da mixagem junto com a gravação. Sem dúvida o processo mais demorado é o da edição, que consiste em compilar os melhores takes gravados e formar o áudio final. Isso requer muita organização para que tudo flua com rapidez e qualidade.

O processo tradicional

No processo tradicional de produção, o locutor narra o texto de uma só vez, garantindo a fluidez e o ritmo do texto. Quando acontece algum erro ele regrava do ponto que parou e segue gravando o texto seguinte. Dá para imaginar que ao final de uma gravação de um texto de 10 minutos, temos um áudio bruto de 30 minutos ou mais. Após a gravação, o engenheiro pacientemente tem que ouvir todos os trechos novamente e escolher o melhor deles. Essa escolha é feita arrastando os melhores takes para uma track de áudio abaixo da original.

Um pouco tedioso, não? Além de demorado.

Uma nova abordagem

Pensando em otimizar o tempo, desenvolvi uma outra maneira de trabalhar com edições de locuções que me permitiu ter o áudio final no mesmo instante que o locutor acaba de gravar. Essa nova maneira de pensar está presente no meu curso online de Pro Tools e hoje quero te mostrar como é fácil e super ágil.

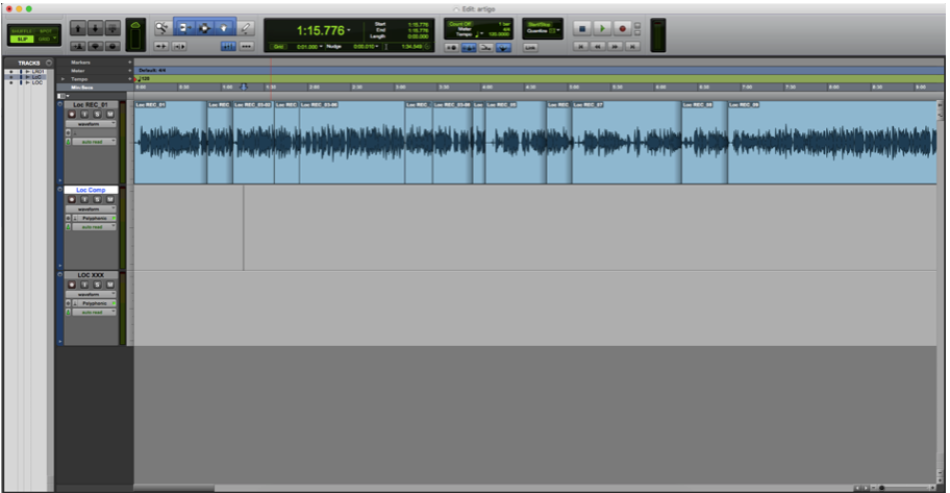

Primeiramente, criamos três tracks de áudio. A primeira track será para gravar, a segunda para guardar os melhores takes e a terceira para juntar os melhores pedaços e formar o áudio final.

O grande truque vem agora. O locutor dificilmente gravará o texto sem nenhuma interrupção. Com certeza ela irá parar por conta de um erro ou mesmo falta de fôlego. Assim que ele interromper, pare a gravação com a barra de espaço e imediatamente coloque o cursor do Pro Tools um pouco para frente. Comece a gravação novamente. A grande vantagem é que enquanto ele grava o trecho seguinte, você pode ir arrastando para baixo o melhor trecho anterior que foi gravado. Se você estiver trabalhando junto com um diretor de locução fica ainda mais fácil, pois ele pode falar para você qual foi o melhor trecho que ouviu anteriormente.

Enquanto o áudio da frente é gravado, coloque os melhores takes anteriores na track de baixo

Depois de terminada a gravação, você já estará com os melhores takes selecionados. Agora basta formar o áudio final. Arraste todos eles para a última track e pronto! Sua locução final está montada. Pra ficar ainda mais fácil, ative o modo shuffle do Pro Tools para que os áudio “colem” nas bordas uns dos outros.

Agora você pode fazer um ajuste fino em cada corte, colocar um fade e começar a mixar!

Tutorial áudio

Vídeo: Qual a importância do summing analógico no processo das masterizações musicais?

Qual a importância do summing analógico profissional em suas músicas durante o processo de masterização.

Com a maior conectividade das plataformas digitais e a execução on-line ou para download de áudios com taxas de amostragem mais altas, abriu-se espaço para masterizações na versão HI-FI, e nesse vídeo explico que o processo do summing analógico é uma excelente opção para adquirir mais qualidade em sua música por conseguinte a exceção em sistemas de streamings HI-FI ou em sistemas de sons tambem em HI-FI.

-

Eventos3 dias ago

Fachada da Prefeitura de São Paulo é iluminada com logo do AC/DC

-

Eventos4 dias ago

Monsters of Rock 2026 terá Guns N’ Roses como headliner

-

Audio Profissional3 dias ago

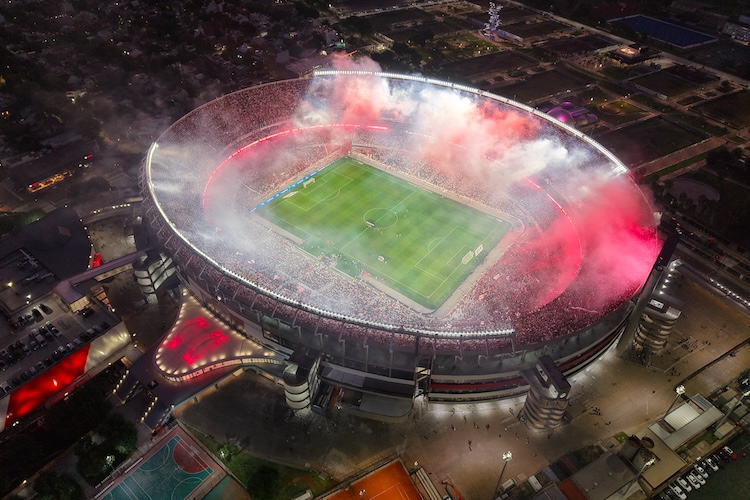

WSDG aprimora o som e a segurança no estádio do River Plate na Argentina

-

Eventos4 dias ago

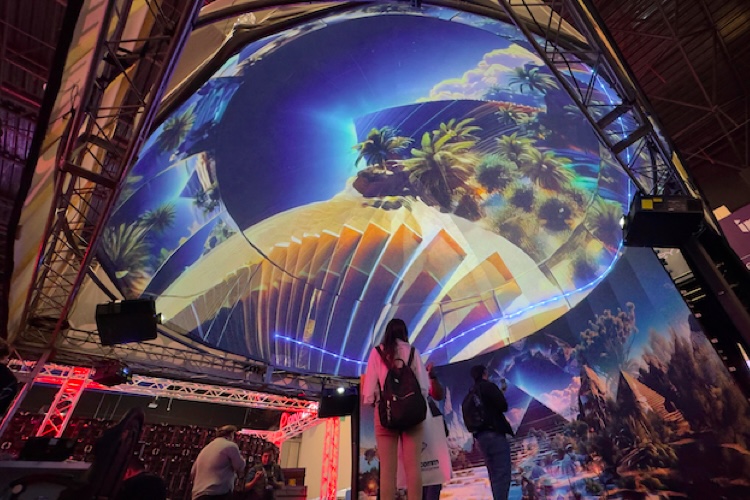

InfoComm América Latina 2025 reuniu mais de 5.000 participantes no México

-

Empresas1 semana ago

Falece aos 73 anos, Jorge Menezes, fundador da Cheiro de Música: uma trajetória de pioneirismo no varejo musica

-

Audio Profissional3 dias ago

Power Click lança o Voice Monitor MK II: controle total de retorno para cantores e locutores

-

Lojista4 dias ago

Dicas para melhorar a logística de assistência técnica e pós-venda

-

Instrumentos Musicais5 dias ago

KORG anuncia mudanças: Miyou Kato assume como CEO e Hironori Fukuda como COO

Noise Generator

Noise Generator Filter

Filter LFO 1 and LFO 2

LFO 1 and LFO 2 Envelopes

Envelopes Global Settings

Global Settings Delay

Delay Reverb

Reverb Gater

Gater Distortion

Distortion