Inteligência artificial – Parte I. 95% da música veiculada pelos meios de comunicação atuais tem suas raízes no sistema tonal, trilha sonora do racionalismo dos séculos XV ao XIX.

Parâmetros musicais como tempo forte e fraco, consonância e dissonância, pergunta e resposta e outros contrastes estão caducos. A evolução humana não se limita ao racional, e o grande mestre Hans-Joachim Koellreutter nos legou o conceito de “arracional”.

Quando digo “nos” legou, me incluo no universo dos 5% de adeptos da produção musical que escapam da mesmice, se esforçando na criatividade atada pela indústria musical, que paradoxalmente busca o novo – comercial – dentro das estruturas composicionais como elemento de atração para um público fortemente enraizado – para não dizer prisioneiro – do racionalismo e do sistema modal, tonal, etcetera e tal.

A partir do século XX a música passou a se estruturar de outra maneira, e as composições se libertaram de algumas amarras, enquanto o público nem sempre acompanhando tais mudanças, razão pela qual persistem, em pleno século XXI, alguns problemas que atingem a quem queira se aventurar pela produção musical contemporânea, sempre lembrando que produzir música é compor música.

Segundo as palavras do próprio Koellreutter: “…o artista tem a função de conscientizar através de sua obra, subordinando sua estética a este mundo novo, para conscientizar esta ideia. Esta é a minha opinião pessoal (dele e minha)). Ao mesmo tempo, apelo a vocês, porque só assim nós poderemos criar uma cultura humana e humanista.” (1987). Posto isto, voltemos um pouco no tempo às origens da IA – Inteligência Artificial.

O NASCIMENTO DA INTELIGÊNCIA ARTIFICIAL

Gates Hillman Complex – Carnegie Mellon University

Iniciada depois da Segunda Guerra Mundial, seu estudo começou nos anos 50 do século XX no primeiro laboratório de inteligência artificial na Carnegie Mellon University, Pittisburgh/EUA, com Herbert Simon, Allen Newell, John McCarthy e outros, e buscava, através da linguagem de máquina, construir dispositivos que imitassem o pensamento humano, opondo-se ao pensamento humanista, com o paradoxo de imitá-lo.

E o que tem a produção a ver com isto? Tudo. As conhecidas estações de trabalho de áudio digital, as DAWs – Digital Audio Workstations – e seus plug-ins, consistem num grupo de instruções que um programador de computador cria. Por exemplo, quando um plug-in de compressão processa uma gravação de voz, ele responde às suas configurações e à dinâmica do material gravado em direção a um resultado.

Isso pode ser muito prático, mas a efetividade depende totalmente em como se configurar os parâmetros de compressão. Uma gravação vocal diferente vai requerer diferente relação de compressão, e diferente cadeia de processamento. Mesmo contando com padrões, um software convencional pode não ajudar muito nas nossas decisões de configurações.

Nesse momento, vamos recorrer às nossas experiências no passado e às etapas de aprendizado para decidir como configurar a compressão para a nova gravação de voz. Já um software de inteligência artificial poderia emular estas etapas de aprendizado. Um compressor baseado em IA poderia descobrir sozinho qual a melhor configuração, através da análise de uma grande quantidade de gravações de voz.

O software baseado em IA poderia construir um modelo matemático de compressão ideal e aplicá-lo a novas gravações, comparando com os padrões que aprendeu, e com isso configurar o compressor baseado na sua experiência adquirida em vez da nossa própria experiência. Este software poderia aplicar este modelo aprendido em outras gravações para automaticamente ajustar a compressão.

Fica a pergunta: quem de fato estaria criando as configurações de compressão, o operador do plug-in ou as talvez milhares de experiências “aprendidas” pelo programa? E em se tratando de composição, quem seriam os autores dos incontáveis procedimentos melódicos, harmônicos e rítmicos, se aplicarmos a mesma dúvida do exemplo de compressão a um de composição musical?

Um guitarrista que se colocasse a analisar, transcrever e executar centenas de riffs e licks de outros guitarristas, de forma a não repetir estilos, frases e ideias, e a partir desse aprendizado iniciasse uma composição própria, seria o autor da novidade, ou simplesmente estaria eliminando todas as possibilidades anteriormente conhecidas, em um caminho inverso ao acerto do compressor baseado em IA?

CANTAROLAR, MURMURAR, SUSSURRAR OU ENGANAR?

Entro no assunto composição ao me deparar com um aplicativo chamado Humtap, que segundo seu CEO Tamer Rashad, investiu 100 mil horas de pesquisa e desenvolvimento com musicologistas, artistas, gravadoras e produtores para transformar um cantarolar em canção no estilo do seu artista favorito, em poucos segundos e em tempo real no celular. O verbo “hum” traduz-se por cantarolar, murmurar, sussurrar e… enganar.

Desde os tempos do Quadrivium na Grécia Antiga – que compreendia a Astronomia, Geometria, Matemática e Música – nunca se viu uma simplificação capaz de regredir a séculos de desenvolvimento criativo, e mais: fazendo uso do progresso da ciência para reduzir a arte a uma cópia de esforços criativos alheios, e, temo ainda, que de uma qualidade no mínimo duvidosa.

Não estamos mais falando de comprimir uma voz, mas da produção de um álbum por pessoas sem nenhum treinamento musical, equipamento de estúdio, recursos financeiros ou auxílio de um produtor musical. Ainda em 1996, o compositor José Miguel Wisnik se referia a este acúmulo de experiências humanas e seu resultado histórico, como uma evolução natural do desenvolvimento artístico e musical:

“Entre os séculos IX e XVII, o sistema tonal foi sendo construído até desembocar em Bach, que pôde fazer o que fez porque recebeu um código preparado durante séculos. Ele foi o auge e o limite de uma racionalidade que se constituiu questionando seus próprios fundamentos. A razão ocidental se desenvolveu dessa forma, pondo em xeque os seus princípios”.

E continua: ”A partir do século 18, com Beethoven, e principalmente com seus sucessores como Wagner, o tonalismo incorpora a dissonância, torna problemática a estabilidade harmônica, até chegar às experiências do século 20, que demandam uma saída que extrapola seus fundamentos”. A arte acompanha a evolução humana, e por mais que a ciência ajude, um robô será sempre criação humana. E completa:

“Nós estamos vivendo uma mutação antropológica que desafia a razão do mundo da escrita, a razão linear e a razão que supunha uma autonomia. Pode haver um desgarramento do tecido social se nós, enquanto animais simbólicos, não conseguirmos elaborar essa situação”, terminou Wisnik, contrapondo, mais de 20 anos atrás, um dilema só agora tornado assunto dos leigos e dos profissionais da arte e da ciência.

O QUE ROLA HOJE NAS REDES SOCIAIS

Voltando a procedimentos de áudio, Pascal Pilon, do site de colaboração, distribuição e promoção musical LANDR, adiantou à revista SoundOnSound inglesa que processam mensalmente mais masterizações do que todos os estúdios dos EUA reunidos: cerca de 330 mil. Outras plataformas como a CloudBounce oferecem serviços de master, restauração e produção de áudio. Só no YouTube 300 horas de vídeo sobem por minuto.

A CloudBounce planeja transformar-se em algo mais coletivo, que seu integrante Anssi Uimonen batiza de um “ecosistema dirigido pela comunidade” – dBounce – onde cada usuário de composição, mixagem e masterização usará o sistema como um “produtor de áudio de IA”, aplicando algoritmos para vários procedimentos, que irão aprendendo tarefas nos diferentes gêneros.

Produtores poderão participar da dBounce ensinando algoritmos específicos, e serão recompensados via tokens quando seus algoritmos forem usados. Uma plataforma de plug-ins, outra de remoção de ruídos ou de ambiência, e outras ideias estão nascendo. Algo como os royalties que empresas de bibliotecas de timbres como a Spitfire, remuneram os músicos que as gravam, parece estar surgindo no campo da IA.

Alguma sinceridade em Tamer Rashad que afirma “menos de 1 por cento da população pode realmente contribuir para a criação musical”. Drew Silverstein, da Amper Music, adjetiva: “Todo mundo tem ideias criativas. O desafio não é ter a ideia, é descobrir como expressar a ideia.” E Dror Ayalon, da Soundscape, suaviza: “O futuro é basicamente a combinação entre o trabalho humano e a máquina. Não se trata de substituir o homem.”

Enquanto isso, na terra da Lei de Gerson – “É preciso levar vantagem em tudo, certo?” – as redes sociais são o habitat natural de muita gente fascinada pela arte, mas que vê a atividade artística como supérfluo. Estranhamente, da mesma forma que paga ingresso para uma partida de futebol sem reclamar, procura por formação musical gratuita para aprendizados que vão de tocar um instrumento a se tornarem produtores musicais.

Para estes, aplicativos de IA que os aproximam de outros com as mesmas ideias são atraentes. Quando é exibido o custo ou o preço – e quase todos não diferenciam as duas coisas – de um aprendizado sério, relutam em pagar e seguem procurando informações gratuitas, muitas vezes irreais. Pior: são capazes de questionar qualquer didática eficiente baseados no empirismo de um sonho de instrumentista irrealizado.

Estas pessoas podem se tornar um mercado consumidor movido a IA, seja transformando ouvintes passivos em criadores musicais, ou abrindo oportunidades para que qualquer apaixonado pela música, independente de suas habilidades técnicas, tenha alguma experiência musical. Tamer sugere a imagem de uma adolescente em um vilarejo da África, sem acesso a facilidades de estúdio, colaborando com seu artista favorito apenas com seu smartphone.

OS AVÓS DA INTELIGÊNCIA ARTIFICIAL EM IP DISCADO

Tim Bran

A ideia tem seus avós… Em novembro de 1994 o compositor, produtor e músico da banda Londonbeat Willy Henshall, e Tim Bran, engenheiro, produtor e músico da banda Dread Zone iniciaram o Res Rocket Surfer Project, que visava a possiblidade de músicos tocarem online e simultaneamente usando um servidor de FTP – File Transfer Protocol – e emails. Era o período informático pré-interface gráfica, ou a Escuridão do DOS…

Começaram postando mensagens e arquivos de som em um BBS – Bulletin Board System – pequena rede de usuários precursora da Internet – e em seguida em um site no oeste de Londres. Pessoas do mundo todo ficavam atentas e trocavam arquivos de som. Vale lembrar que a Internet só chegou ao Brasil em 1996, e antes disso, eu mesmo fui soundesigner no ACME BBS no bairro do Mandaqui, em Sampa.

Em janeiro de 1995, quando era lançado no Brasil o Windows 95, a Res Rocket já tinha 600 membros, e sua mailing list era uma “coleção de curiosidades bem humoradas, enquanto as colaborações no site foram crescendo e ficando mais focadas”, segundo Henshall. Democraticamente, o projeto foi rebatizado com o nome votado entre uma lista de 10 sugestões: Res Rocket.

Em abril, dois ingleses se juntaram a Canton Becker e Matt Moller, da Universidade de Chicago, que criaram um ambiente virtual que possibilitava ações de multiusuários em tempo real: um “MIDI-MOO”, que seria chamado, ainda em sua versão Beta, de DRGN – Distributed Realtime Groove Network. A plataforma no Brasil era dos PCs 286, 386 e 486, com seus potentes HDs de 1, 2 e até formidáveis 4 Gb.

Em maio de 1995 construíram o Res Rocket Surfer Website, comissionados pela Netmare, que testou o DRGN com membros de bandas, o que deu destaque internacional ao projeto, que ganhou o título de “Cool Site of the Day”, da Netscape, com 150 mil hits em 24 horas. O software fora lançado duas semanas antes no Intel New Music Festival. Por módicos US$ 14.95 mensais, usuários podiam participar escolhendo entre estúdios de gravação públicos, sessões de improviso ou chats com o tema música.

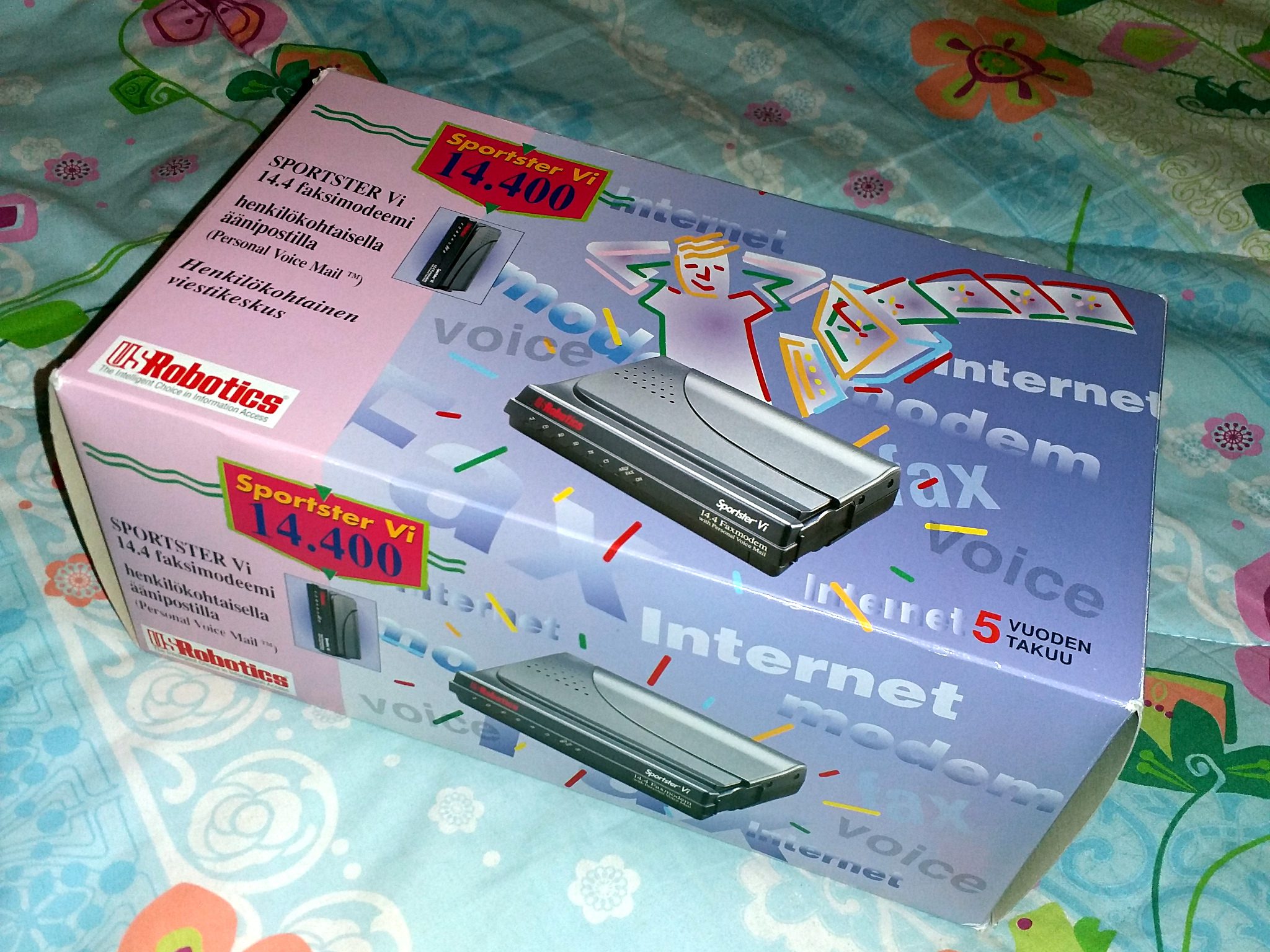

Para tocar, os músicos precisavam usar instrumentos MIDI, e cada um, representado por um avatar, podiam tocar em tempo real, ou trabalhar sua parte para mixar depois. O protocolo MIDI completava seus primeiros dez anos, e parecia se combinar muito bem pelo tamanho reduzido dos arquivos com as precárias condições de conexão via IP discado em modems US Robotics de 14.400, 28.800 e até 56 Kbps.

Em agosto de 1997 a versão oficial do DRGN estava disponível, e aos fundadores se juntou Paul Allen, dando qualidade profissional às gravações. Em dezembro de 1998 o software ganhou a versão 1.4 para Windows e a versão 1.2.1 para Mac. Ambas suportavam MIDI Import e Export, tornando possível trabalhar com os arquivos online e offline, mais estabilidade, implementações HTML, extinção de vários bugs incômodos e um comunicador para diálogos entre os participantes.

Em março de 1999 o projeto foi usado para gravar um cover da canção Them Belly Full, de Bob Marley, diante de 55 milhões de espectadores em uma hora. A canção serviu ao evento de caridade War Child, com as participações de Sinead O’Connor no vocal em Londres, Thomas Dolby nos teclados em São Francisco, e vocais de Lucky Dube na África do Sul. O evento foi gravado ao vivo pela BBC TV, e contou ainda com músicos de New Orleans, Los Angeles e Nova Iorque, e a venda da gravação se deu só pela Internet, com a renda para o War Child.

A Yesmate.com e a Magex lançaram um CD gratuito da gravação, com bônus em MP3 da comunidade de artistas Yesmamma, produtores e DJs, e rendeu 50 mil cópias segundo a edição de julho de 2000 da UK DJ Magazine. A Magex cobrou US$ 1.50 de doação e continha 6 horas e 30 minutos de material. Em dezembro de 1999 foi lançado o RocketPower, com o qual as pessoas podiam ter seu próprio estúdio online na rede.

Os grandes desenvolvedores de DAWs da época – Steinberg e Emagic – desenvolveram novas versões que possibilitavam as usuários produzir áudio via Internet. Versões Beta do novo RocketPower foram entregues a Beta testers, que tinham acesso aos estúdios na Internet. à Rocket Network Pro e upgrades das novidades. Em abril de 2000 se começou a usar o Rocket Power como plug-in do Cubase VST.

Em agosto de 2000 o projeto foi comprado por conglomerados empresariais inimigos, e morreu “na geladeira” em março de 2003. O grupo se dispersou, restando Canton Becker com alguns direitos que detém até hoje. As últimas palavras de Canton:

“I left Rocket in August 2000, when it simply became to big and corporate for my tastes (and when I couldn’t make much of a difference anymore in the face of marketing-driven development). They are so many cool things that ought to be made, but there’s not enough time to make them all by yourself. But when you get the wrong folks involved to help, the dream gets spoiled…”

Tecla SAP: “Saí da Rocket em agosto de 2000, quando o projeto ficou grande demais e corporativo demais para o meu gosto (e quando eu não fazia mais muita diferença diante do desenvolvimento dado pela direção de marketing). Havia muitas coisas legais que poderiam ser feitas, mas não havia tempo suficiente para fazer tudo sozinho. Mas quando você tem as pessoas erradas envolvidas para ajudar, o sonho vai pro saco…”

Terminamos essa parte de nossa incursão pela IA com o sempre atual Koellreutter: “É mais difícil perceber e entender uma nova linguagem, mas essa dificuldade é humana. Se os elementos utilizados pelos novos compositores são diferentes, o vocabulário é outro, a sintaxe tem de ser outra, a gramática é nova, o que dificulta a compreensão dos valores emocionais da música. Essa situação exige um ouvinte mais ativo e co-participante: no fundo, a relação entre o compositor e o público deve ser diferente.”